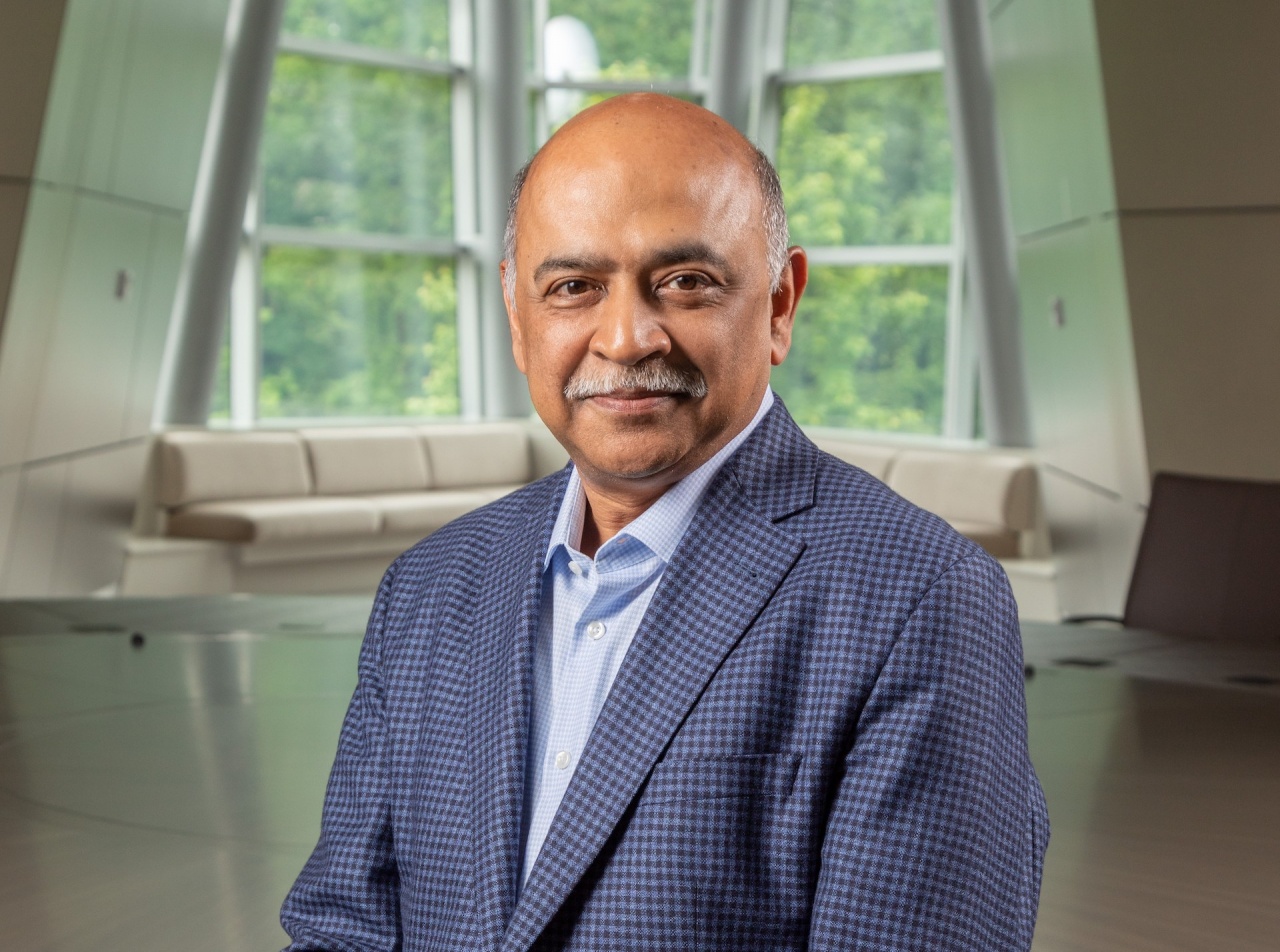

Il CEO Arvind Krishna spiega che l'AI deve essere aperta e personalizzabile, perché qualsiasi modello chiuso è insostenbile

Autore: f.p.

Le call con gli analisti finanziari che i top manager delle aziende IT tengono ogni trimestre sono utili per approfondire le "aride" cifre ma anche, e soprattutto, per capire meglio come le stesse aziende vedono l'evoluzione dei principali temi tecnologici intorno ai quali operano. Nel caso specifico di IBM, che da poco ha chiuso il suo secondo trimestre finanziario del 2024, il tema caldo è stato il futuro possibile sviluppo dell'AI.

IBM ha puntato decisamente sulla AI generativa come componente tecnologico trasversale a molte soluzioni, anche a marchio Red Hat. La visione di IBM, a questo punto, è che per la GenAI non vedremo il predominio di pochi grandi LLM gestiti dai grandi nomi dell'IT e dell'AI, come alcuni avevano previsto all'inizio del boom dell'AI generativa. IBM punta invece sulla presenza di una moltitudine LLM di dimensioni più piccole - fino agli Small Language Model - e mirati in modo specifico su domini verticali. Questa specializzazione degli LLM sarà guidata non solo dalle software house, ma anche degli utenti stessi.

"I grandi modelli general-purpose vanno molto bene per affrontare i primi casi d'uso dell'AI - ha spiegato Arvind Krishna, Chairman e CEO di IBM - ma i clienti rilevano che modelli più piccoli sono essenziali per avere strategie AI efficaci dal punto di vista economico. E sono anche più semplici da personalizzare e ottimizzare".

È il motivo per cui IBM ha deciso di cedere in open source i suoi modelli della famiglia Granite: dare ai clienti la possibilità di costruire proprie applicazioni di GenAI partendo da modelli solidi e collaudati ma anche, ora, ampliabili e personalizzabili liberamente. L'idea è che in campo AI accada quello che è successo in campo OS: la dinamicità e la libertà d'azione offerte dal modello open source risulteranno vincenti rispetto alle soluzioni solo proprietarie.

La filosofia in campo AI di IBM segue quindi, sostanzialmente, il modello che Red Hat ha applicato al software infrastrutturale. Una scelta quasi obbligata, secondo Arvind Krishna, perché le esperienze fatte dalle aziende utenti negli ultimi 12 mesi "hanno reso evidente che per trarre regolarmente valore dall'AI è necessario sfruttare davvero i dati aziendali". Quindi partire da LLM generici e verticalizzarli o potenziarli con dati propri. Difficile farlo senza open source.

Il business della GenAI ha sinora portato nelle casse di IBM - ha spiegato il CFO Jim Kavanaugh, qualcosa come due miliardi di dollari: "L'AI sta agendo da catalizzatore per le aziende che vogliono aumentare i ricavi, ridurre i costi e cambiare il modo di lavorare, creando un'opportunità significativa per noi". In questo senso il contributo di IBM è duplice: da un lato fornire tecnologie di AI ai clienti, dall'altro agire a più altro livello come consulente nei progetti di AI e di modernizzazione. Una attività remunerativa, questa, tanto che i tre quarti dei due miliardi citati prima sono legati proprio alla consulenza.

Questo non dispiace affatto ad IBM, logicamente: Big Blue punta anzi proprio ad affermare IBM Consulting come "il fornitore strategico preferenziale per le aziende che devono affrontare quella che noi chiamiamo la Digital Transformation 2.0 con la GenAI", ha spiegato Kavanaugh. E a farlo velocemente, per conquistare una fetta importante di un tipo di investimenti - quello in consulenza - che nel breve e nel medio periodo non potrà crescere più di tanto per le condizioni macroeconomiche del mercato.

Può apparire strano a chi conosce poco il mondo cosiddetto legacy, ma in questa visione di IBM i mainframe Z hanno un ruolo fondamentale come cuore di architetture di cloud ibrido anche per l'AI. Puntando in primis sulle funzioni AI native dei processori Telum nei sistemi z16, ma anche più in generale sulle funzioni legate alla gestione sicura di grandi moli di dati.

Così il business legato ai sistemi Z è cresciuto dell'8 percento trimestre su trimestre e i mainframe z16, che in fondo hanno già due anni di vita, continuano a "performare" economicamente meglio dei modelli precedenti. Come mai? Perché di fronte alle necessità dei grandi clienti i mainframe continuano a rappresentare una combinazione tecnologica ideale: "sviluppo cloud-nativo per il cloud ibrido, AI integrata su scala, sicurezza quantistica, efficienza energetica e forte affidabilità e scalabilità... IBM Z rimane una piattaforma duratura per i carichi di lavoro mission-critical, che spinge l'adozione sia dell'hardware che del software, dello storage e dei servizi correlati", ha ribadito Kavanaugh.

Andando anche oltre i sistemi Z, per IBM sarà sempre più importante lato AI poter contare su solide piattaforme enterprise che si possono implementare anche on-premise. Perché per le grandi imprese far girare modelli di AI solo nel cloud pubblico è economicamente impossibile: parlando con gli analisti Arvind Krishna ha citato il caso di un cliente che deve gestire circa due miliardi di transazioni al giorno, che a farlo in cloud costerebbe qualcosa come un centinaio di milioni di dollari al giorno.

"Se si esegue un modello estremamente grande su cloud pubblico, il modello sarà per sua natura costoso perché un modello molto grande ha bisogno di molto più computing, molto più networking, molto più storage, molta più memoria... Se si riesce a ridurre le dimensioni del modello, si può ridurre tutto questo del 90%... Se si riesce a farlo funzionare utilizzando alcune delle nostre tecnologie Red Hat on-premise, è possibile ridurlo di un altro 50%", ha spiegato Krishna.

Al netto delle cifre in sé, la strada è chiara. Si può passare dagli LLM "tuttofare" a Small Language Model grandi un decimo che, però, nel loro dominio specifico danno risultati paragonabili e anche migliori, potendo inoltre essere arricchiti con i dati dell'azienda utente. Dati che restano ben tutelati, al sicuro e privati. Aver ceduto i modelli Granite in open source permette proprio questo, spiega Krishna: "offre ai nostri clienti la libertà di tenere per sé ciò che aggiungono al nostro modello aperto di base".

E, anche in questo caso come è accaduto per Linux, IBM non vede nell'open souring dell'AI un pericolo per gli affari. "Non sono preoccupato di cedere la proprietà intellettuale", ha commentato il CEO di IBM: "Le aziende cercano patch, sicurezza e retrocompatibilità... Ci sono molte ragioni da enterprise per cui le aziende continueranno a lavorare con noi. Ma l'open source ci permette di espandere il mercato ai milioni di sviluppatori che utilizzano Linux e che possono sperimentare, creare le loro innovazioni e poi restituirle alla comunità. O anche tenerle per la loro azienda".