Le aziende clienti preferiscono i dati on prem o in piccoli data center locali: grande notizia per chi vende infrastruttura.

Autore: Valerio Mariani

Il crescente interesse per l’AI dimostrato anche dalle aziende italiane e le sempre più chiare direzioni di sviluppo rappresentano un’interessante opportunità anche per chi, come Dell Technologies, si focalizza da sempre sull’hardware.

Che l’AI abbia bisogno di potenza di calcolo, e di macchine all’altezza, non è certo una novità, ciò che cambia è l’estensione del mercato potenziale dai data center delle strutture di hosting e delle aziende più grandi a strutture più contenute che servono realtà di medie dimensioni e soddisfano l’esigenza del controllo dei dati in prossimità dello stesso mercato enterprise.

Alla tappa di Milano del Dell Technologies Forum 2024, il presidente Emea, Adrian McDonald, ha ribadito la visione già condivisa al Dell Technologies World dello scorso maggio a Las Vegas. Per chi non c’era, McDonald ha ricordato i cinque principi che devono guidare l’adozione dell’AI.

Leggi la cronaca completa del Dell Technologies World di Las Vegas

Il primo è già una sentenza: secondo le rilevazioni di Dell, l’85% dei clienti ha, e intende mantenere, i dati on prem, mentre il 50% sta pensando allo sviluppo di strutture edge in un ottica di cloud ibrido. È tutto qui il senso dell’offerta Dell Technologies per l’AI: fornire soluzioni hardware adeguate di elaborazione e di storage alle aziende clienti per infrastrutture locali e contenute.

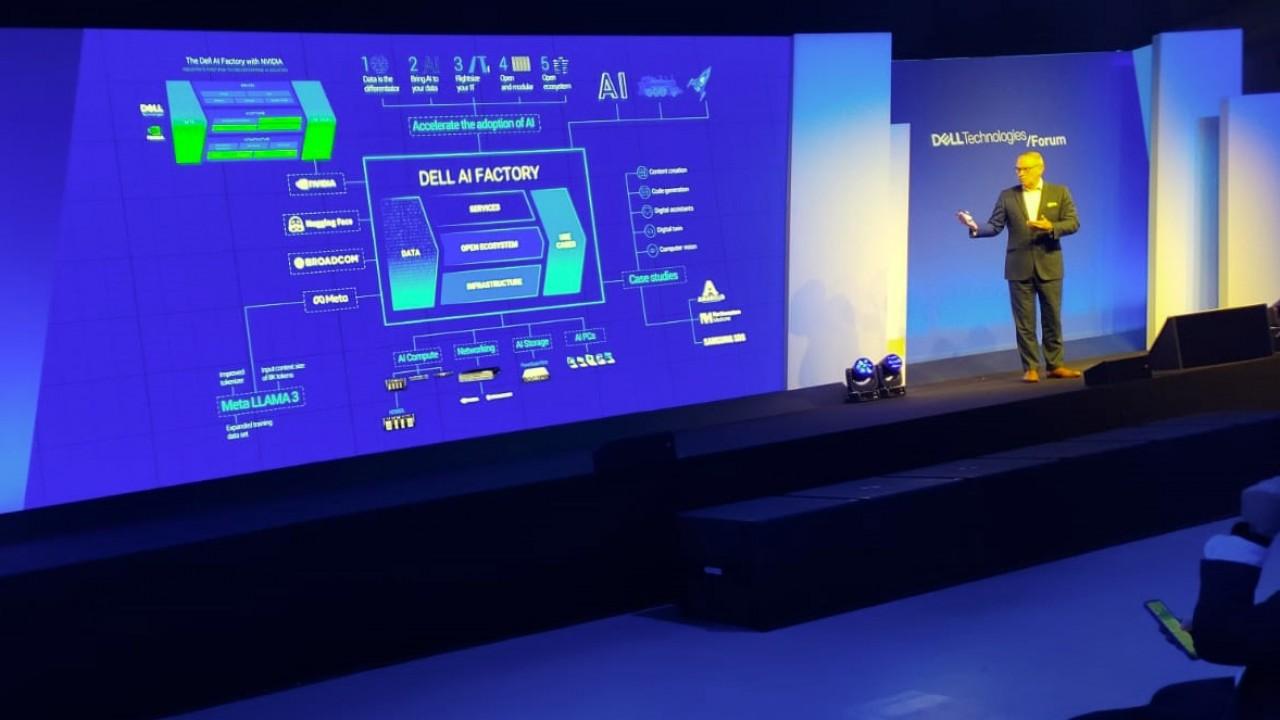

La visione dell'azienda prosegue suggerendo i principi “bring AI to your data”, “right size your IT”, “be open and modular” e, infine, favorire un “open ecosystem” per accelerare l’adozione dell’AI garantendo sicurezza e sostenibilità.

Si tratta di portare l’AI ai dati locali e ben protetti, custoditi in ambienti edge e/o on prem, attraverso un approccio modulare e scalabile a partire da un’analisi molto precisa dello stato dell’arte dell’IT del cliente e in un’ottica di piena collaborazione con l’ecosistema di fornitori leader. Ovvero, per Dell sono i soliti noti: Intel, Nvidia, Microsoft, Amd, Qualcomm, Broadcom nella declinazione VMware e Red Hat a cui si aggiungono Cloudera, Databricks, Hugging Face, Meta, Snowflake e Teradata.

È, in definitiva, il modello della Dell Technologies AI Factory già vista a Las Vegas in cui per la parte di infrastruttura svettano la famiglia AI Compute dei server PowerEdge XE9680, quella AI Storage dei PowerScale F910, i Dell PowerSwitch e gli AI PC Dell con Copilot incorporato.

Con il suo intervento, Frediano Lorenzin, Field Chief Technology Officer di Dell Technologies, annuncia l’uscita “dalla fase della tecnologia di nicchia e dell’hype mediatico. Nelle aziende non si parla più di “se” o di “quando” ma di come” prosegue il manager confermando che in un anno tanto è stato guadagnato in termini di consapevolezza delle aziende clienti.

Secondo la ricerca Dell Technologies Innovation Catalyst il 57% delle aziende è in una posizione compresa tra “early” e “mid-stage” nell’adozione della Gen AI e, sempre secondo Lorenzin, i freni riguardano la sicurezza dei dati e le competenze mancanti. Ma, il 79% dei clienti dichiara che gli strumenti AI aumenteranno le capacità umane e la produttività, contribuendo a raggiungere nuovi picchi di innovazione. Ciò significa che la consapevolezza c’è, e anche l’entusiasmo, ma c’è da colmare la mancanza di competenze. Lorenzin sostiene che è necessario un approccio “people-first”, dunque lavorare insieme alle risorse aziendali e modellare il progetto secondo necessità e caratteristiche delle singole risorse dipartimentali.

Mentre, la questione della sicurezza (dei dati) si risolve scegliendoli con particolare cura. Il rischio di perdersi tra dati aziendali inutili e non strutturati si supera “scegliendo esclusivamente quelli pertinenti agli obiettivi definiti – prosegue Lorenzin”, altrimenti si genera entropia, c’è bisogno troppe risorse di elaborazione e il livello di sicurezza si abbassa. Ed è proprio l’ottimizzazione delle risorse hardware, e quindi dei costi, che renderà disponibile l’AI anche alle medie aziende.

La sfida, dunque, riguarda soprattutto i dati, talmente importanti che – secondo Francesco Torricelli, Country Enterprise Director Italy and Iberia di Nvidia: “dovrebbero essere considerati una risorsa nazionale sovrana, esattamente come l’energia e le telco”. E, inoltre, saranno proprio le scelte sui dati a fare la differenza con i concorrenti delle aziende clienti.

Ma con lo spostamento verso l’edge non si rischia di pretendere nuovi investimenti ai clienti alle prese con la quadratura dei conti e l’attesa del ROI successiva all’ubriacatura in tempi di pandemia? Sembra di no secondo Lorenzin: “noi lo vediamo come un investimento ponderato in base alle esigenze e, inoltre, è dimostrato che il TCO e il ROI dell’edge computing sono, rispettivamente, più ridotto e più veloce”.

Questo è lo scenario, mentre ci si aspetta una riduzione del costo dell’hardware progettato per l’AI, una fase di convivenza e integrazione tra modelli diversi e un abbandono della tradizionale fase di training a favore di approcci meno affamati di risorse come l’inferencing.