ARM fa tendenza, ma nel data center?

Il salto di Apple ai processori ARM e il primato del supercomputer Fugaku sono segnali importanti. Abbastanza da cambiare gli equilibri nel data center?

Come era stato ampiamente anticipato, alla fine Apple ha annunciato l'abbandono di Intel. Con il passaggio alla tecnologia che a Cupertino chiamano Apple Silicon. Perché il brand della Mela conta ed è bene estenderlo anche alle CPU. Che il resto del mondo preferirà definire, correttamente, come processori in tecnologia ARM progettati da Apple. E realizzati dal colosso Taiwan Semiconductor Manufacturing Company (TSMC), che produce chip praticamente per tutti i grandi nomi dell'IT.

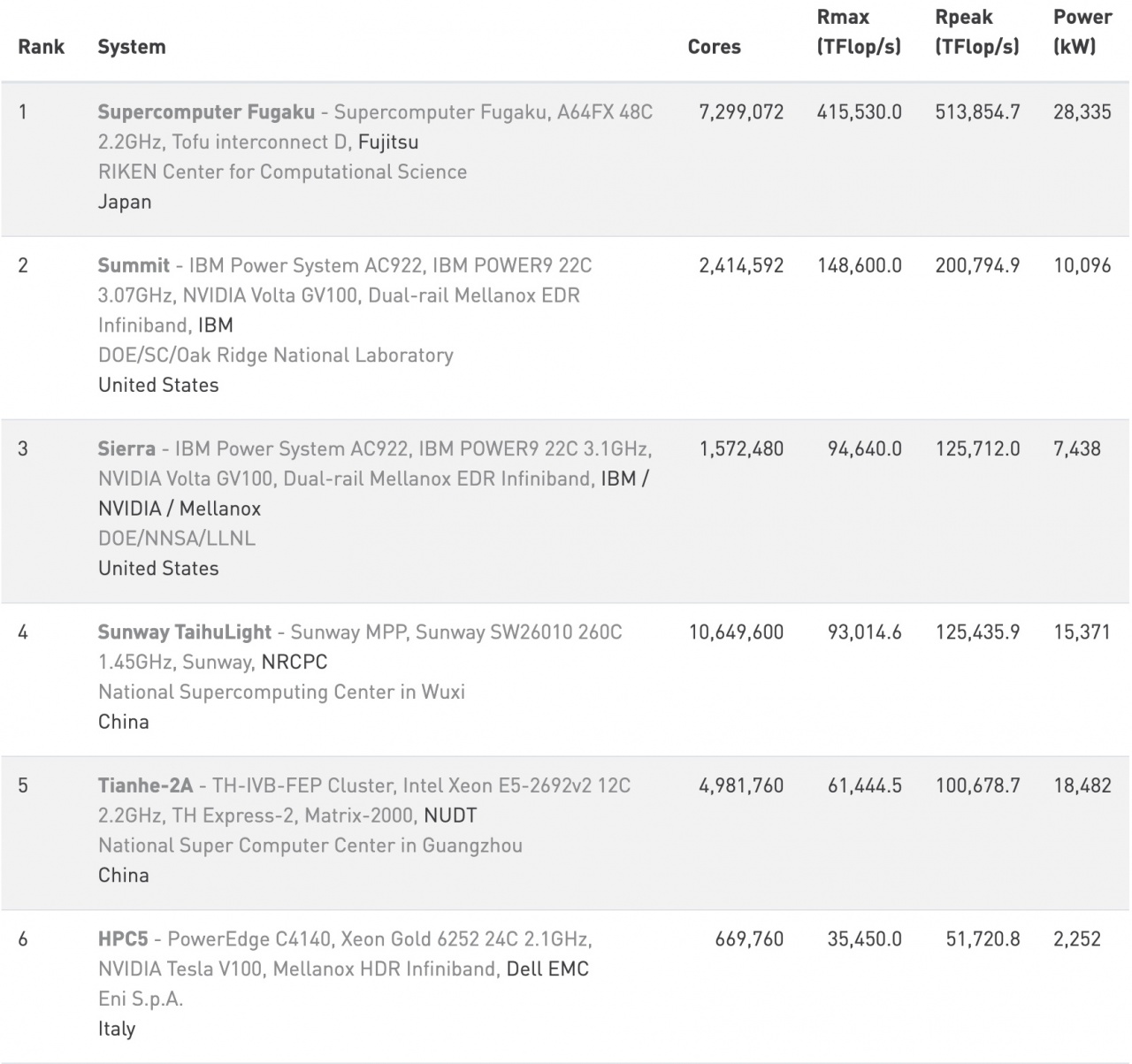

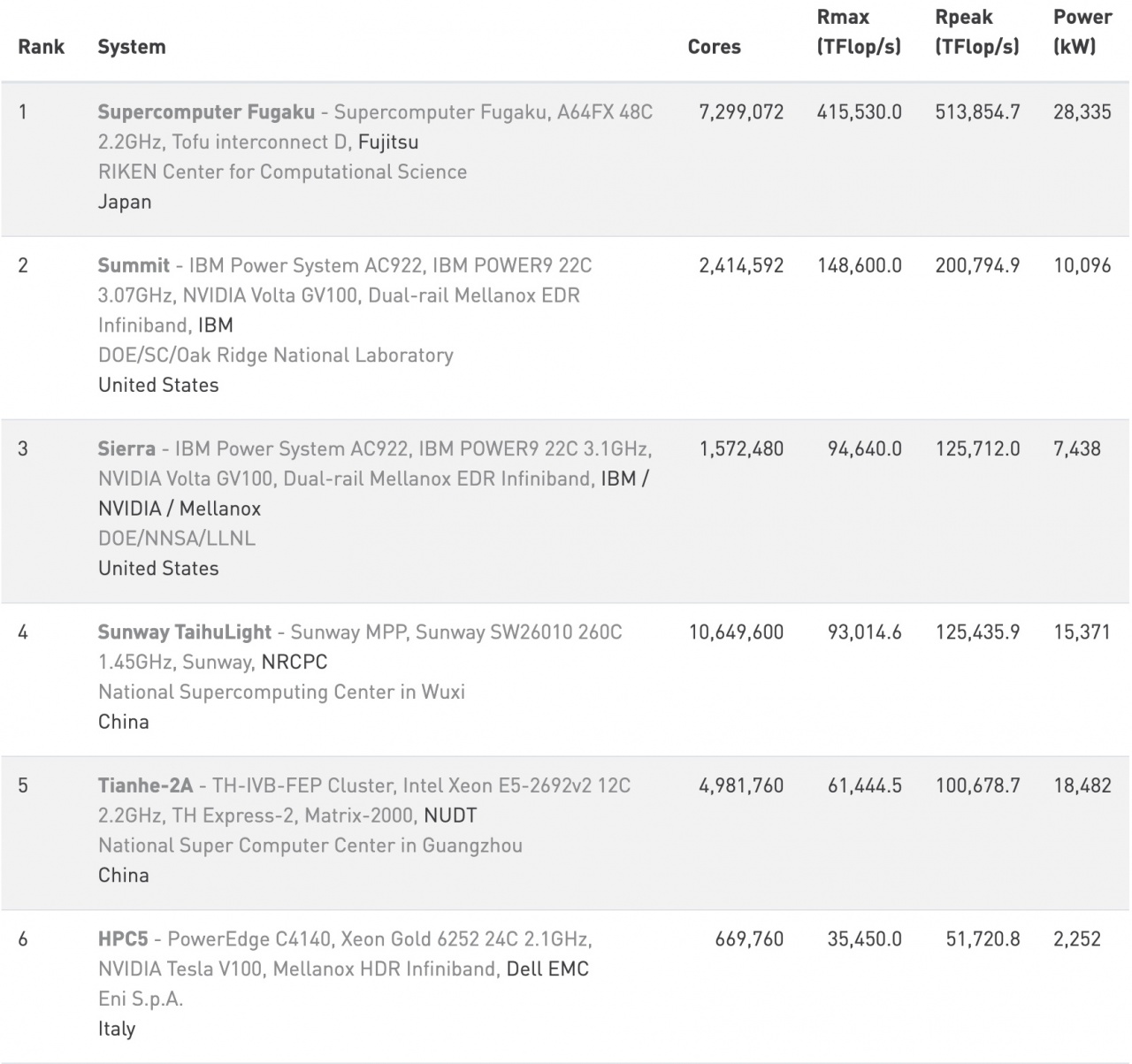

Il caso ha voluto che l'annuncio di Apple fosse quasi contemporaneo con un'altra "vittoria" del mondo ARM. È infatti basato su processori ARM il nuovo top del calcolo ad alte prestazioni. Supercomputer Fugaku, il sistema progettato da Fujitsu, ha largamente superato la concorrenza con una potenza di picco di quasi 514 petaflop. Tiene così a distanza il buon vecchio Summit di IBM, fermo a 201 petaflop di picco. Vale la pena notare che - segno dei tempi - il primo supercomputer basato su processori Intel è solo al quinto posto, a circa 101 petaflop.

Il dominio dei processori in tecnologia ARM in campo mobile è indiscusso da tempo. La futura transizione di Apple è un segno delle possibilità in campo PC. Il successo di di Fugaku in campo HPC fa sperare chi ha sempre pensato che ARM potesse conquistare il mondo server. Sono segnali concreti che indicano un'accelerata del mondo ARM rispetto a quello x64? Di certo non vanno sottovalutati. Ma nemmeno esagerati. Vediamo perché.

Molti osservatori tecnici hanno sottolineato che con Apple si "sdogana", di fatto, in campo PC l'approccio in stile Big.Little che ARM ha sfruttato ampiamente nel mondo mobile. Produrre cioè CPU ibride: con molti core divisi in due tipologie. Alcuni potenti ma ad alto consumo, altri poco energivori ma anche poco potenti. Il modello Big.Little prevede che i core più potenti siano attivati solo quando ci sono da eseguire workload molto esigenti. Nel resto dei casi si usano i core che consumano meno energia.

L'approccio tradizionale vede invece core tutti uguali, "generalisti". Quello che al massimo può variare è il numero dei core attivi e la frequenza operativa di picco (con sistemi come il Turbo Boost di Intel). Complessivamente, l'efficienza energetica in questi casi è minore. Puntare su CPU ibride è un approccio che può funzionare su PC magari anche potenti, che devono eseguire spesso workload esigenti? E sui server? Le perplessità non mancano.

La primissima parte della classifica Top500 di giugno 2020Tutto dipende da cosa deve fare un PC o un server con una CPU ibrida. Man mano che il carico elaborativo aumenta, diventano prevalenti i core "performanti" perché sono quelli in funzione per più tempo. Quindi, se immaginiamo un PC o un server sottoposto a un carico rilevante per tempi prolungati, i core poco energivori quasi scompaiono. Di fatto torniamo al modello di funzionamento tradizionale. Le CPU ibride sembrano quindi plausibili per computer, notebook o desktop, sostanzialmente generalisti. I server? Molto meno.

La primissima parte della classifica Top500 di giugno 2020Tutto dipende da cosa deve fare un PC o un server con una CPU ibrida. Man mano che il carico elaborativo aumenta, diventano prevalenti i core "performanti" perché sono quelli in funzione per più tempo. Quindi, se immaginiamo un PC o un server sottoposto a un carico rilevante per tempi prolungati, i core poco energivori quasi scompaiono. Di fatto torniamo al modello di funzionamento tradizionale. Le CPU ibride sembrano quindi plausibili per computer, notebook o desktop, sostanzialmente generalisti. I server? Molto meno.

Un messaggio che Fugaku di certo manda è quanto sia importante per il mondo ARM puntare su un approccio pesantemente multicore. Fugaku di core ne ha ben 7,3 milioni. Per fare un esempio legato a server ARM molto più standard - i classici modelli rack da due socket - quelli di Ampere si basano su CPU Altra a 80 core. In futuro sui processori Altra Max a 128 core. Un bel numero rispetto alle CPU equivalenti x64.

Il punto, si sa, è che avere tanti core non vuole per forza dire mettere a terra tanta potenza. I core a disposizione devono essere tutti sfruttati appieno per essere efficienti. Quindi devono sostenere applicazioni con un elevato grado di parallelismo. O perché sono progettate per averlo, o perché girano su ambienti che lo possono prevedere. Come le applicazioni cloud-native gestite da un elevato numero di container.

Non è semplice tenere impegnati decine, o milioni, di core allo stesso tempo. Oltre che il parallelismo dei workload, servono meccanismi e tecnologie per cui i core stessi non entrino in competizione per l'accesso alle risorse "lente" come la memoria e lo storage. Inoltre, i processori con molti core sono comunque costosi e, in campo data center, non un prodigio di efficienza energetica.

Non è semplice tenere impegnati decine, o milioni, di core allo stesso tempo. Oltre che il parallelismo dei workload, servono meccanismi e tecnologie per cui i core stessi non entrino in competizione per l'accesso alle risorse "lente" come la memoria e lo storage. Inoltre, i processori con molti core sono comunque costosi e, in campo data center, non un prodigio di efficienza energetica.

Mettiamo insieme tutti questi fattori e capiamo perché Intel e AMD, che peraltro è molto più multicore-oriented di Intel, sembrano più conservative nella progettazione dei loro chip. Preferendo "appoggiarsi" sull'alto numero di core delle GPU che affiancano i loro processori. E sempre più in prospettiva, sulla programmabilità delle FPGA. In confronto, le soluzioni ARM sono molto più incentrate sulle CPU in sé. Lo scenario, comunque, è in decisa evoluzione.

Infine, un quasi post scriptum. Anche se non c'entra con il tema ARM, va sottolineato che la classifica Top500 di giugno 2020 è un bel vedere per noi italiani. Che tra i primi dieci supercomputer ci siano sistemi americani e cinesi è ormai normale. Stavolta ce ne sono anche due italiani. HPC5 di ENI al sesto posto - il che ne fa il supercomputer più potente in Europa - e Marconi-100 del Cineca al nono. Così l'Italia è l'unica nazione europea con due supercomputer nella top ten. Non c'è male, anche se magari alla prossima classifica tutto sarà già cambiato.

Il caso ha voluto che l'annuncio di Apple fosse quasi contemporaneo con un'altra "vittoria" del mondo ARM. È infatti basato su processori ARM il nuovo top del calcolo ad alte prestazioni. Supercomputer Fugaku, il sistema progettato da Fujitsu, ha largamente superato la concorrenza con una potenza di picco di quasi 514 petaflop. Tiene così a distanza il buon vecchio Summit di IBM, fermo a 201 petaflop di picco. Vale la pena notare che - segno dei tempi - il primo supercomputer basato su processori Intel è solo al quinto posto, a circa 101 petaflop.

Il dominio dei processori in tecnologia ARM in campo mobile è indiscusso da tempo. La futura transizione di Apple è un segno delle possibilità in campo PC. Il successo di di Fugaku in campo HPC fa sperare chi ha sempre pensato che ARM potesse conquistare il mondo server. Sono segnali concreti che indicano un'accelerata del mondo ARM rispetto a quello x64? Di certo non vanno sottovalutati. Ma nemmeno esagerati. Vediamo perché.

ARM sui PC: potenza o efficienza?

Partiamo dal mondo PC, prendendo Apple come ipotetico modello di produttore di chip ARM per PC e server. E paragonandola ad altri, molto meno noti, produttori di CPU ARM per il mondo server. Apple ha indicato che i processori Apple Silicon avranno una elevata potenza per Watt dissipato, ma non ha mai affermato che saranno mostri di potenza pura. L'attenzione viene così spostata verso il rapporto tra potenza di calcolo e consumo di energia. Un tema ben affrontato nel mondo mobile ma che in quello PC ha avuto una vita sempre difficile.Molti osservatori tecnici hanno sottolineato che con Apple si "sdogana", di fatto, in campo PC l'approccio in stile Big.Little che ARM ha sfruttato ampiamente nel mondo mobile. Produrre cioè CPU ibride: con molti core divisi in due tipologie. Alcuni potenti ma ad alto consumo, altri poco energivori ma anche poco potenti. Il modello Big.Little prevede che i core più potenti siano attivati solo quando ci sono da eseguire workload molto esigenti. Nel resto dei casi si usano i core che consumano meno energia.

L'approccio tradizionale vede invece core tutti uguali, "generalisti". Quello che al massimo può variare è il numero dei core attivi e la frequenza operativa di picco (con sistemi come il Turbo Boost di Intel). Complessivamente, l'efficienza energetica in questi casi è minore. Puntare su CPU ibride è un approccio che può funzionare su PC magari anche potenti, che devono eseguire spesso workload esigenti? E sui server? Le perplessità non mancano.

La primissima parte della classifica Top500 di giugno 2020Tutto dipende da cosa deve fare un PC o un server con una CPU ibrida. Man mano che il carico elaborativo aumenta, diventano prevalenti i core "performanti" perché sono quelli in funzione per più tempo. Quindi, se immaginiamo un PC o un server sottoposto a un carico rilevante per tempi prolungati, i core poco energivori quasi scompaiono. Di fatto torniamo al modello di funzionamento tradizionale. Le CPU ibride sembrano quindi plausibili per computer, notebook o desktop, sostanzialmente generalisti. I server? Molto meno.

La primissima parte della classifica Top500 di giugno 2020Tutto dipende da cosa deve fare un PC o un server con una CPU ibrida. Man mano che il carico elaborativo aumenta, diventano prevalenti i core "performanti" perché sono quelli in funzione per più tempo. Quindi, se immaginiamo un PC o un server sottoposto a un carico rilevante per tempi prolungati, i core poco energivori quasi scompaiono. Di fatto torniamo al modello di funzionamento tradizionale. Le CPU ibride sembrano quindi plausibili per computer, notebook o desktop, sostanzialmente generalisti. I server? Molto meno.Il dubbio del data center

Il primato di Fugaku può dare un segnale positivo per la diffusione di ARM nel mondo server? Certo è un evento in sé interessante. Ma non è facile dire cosa se ne possa estrapolare di nuovo. Rispetto a uno scenario che in realtà sembra abbastanza stabile: chi ha interesse ad avere server ARM già li possiede, gli altri restano alla finestra.Un messaggio che Fugaku di certo manda è quanto sia importante per il mondo ARM puntare su un approccio pesantemente multicore. Fugaku di core ne ha ben 7,3 milioni. Per fare un esempio legato a server ARM molto più standard - i classici modelli rack da due socket - quelli di Ampere si basano su CPU Altra a 80 core. In futuro sui processori Altra Max a 128 core. Un bel numero rispetto alle CPU equivalenti x64.

Il punto, si sa, è che avere tanti core non vuole per forza dire mettere a terra tanta potenza. I core a disposizione devono essere tutti sfruttati appieno per essere efficienti. Quindi devono sostenere applicazioni con un elevato grado di parallelismo. O perché sono progettate per averlo, o perché girano su ambienti che lo possono prevedere. Come le applicazioni cloud-native gestite da un elevato numero di container.

Non è semplice tenere impegnati decine, o milioni, di core allo stesso tempo. Oltre che il parallelismo dei workload, servono meccanismi e tecnologie per cui i core stessi non entrino in competizione per l'accesso alle risorse "lente" come la memoria e lo storage. Inoltre, i processori con molti core sono comunque costosi e, in campo data center, non un prodigio di efficienza energetica.

Non è semplice tenere impegnati decine, o milioni, di core allo stesso tempo. Oltre che il parallelismo dei workload, servono meccanismi e tecnologie per cui i core stessi non entrino in competizione per l'accesso alle risorse "lente" come la memoria e lo storage. Inoltre, i processori con molti core sono comunque costosi e, in campo data center, non un prodigio di efficienza energetica.Mettiamo insieme tutti questi fattori e capiamo perché Intel e AMD, che peraltro è molto più multicore-oriented di Intel, sembrano più conservative nella progettazione dei loro chip. Preferendo "appoggiarsi" sull'alto numero di core delle GPU che affiancano i loro processori. E sempre più in prospettiva, sulla programmabilità delle FPGA. In confronto, le soluzioni ARM sono molto più incentrate sulle CPU in sé. Lo scenario, comunque, è in decisa evoluzione.

Infine, un quasi post scriptum. Anche se non c'entra con il tema ARM, va sottolineato che la classifica Top500 di giugno 2020 è un bel vedere per noi italiani. Che tra i primi dieci supercomputer ci siano sistemi americani e cinesi è ormai normale. Stavolta ce ne sono anche due italiani. HPC5 di ENI al sesto posto - il che ne fa il supercomputer più potente in Europa - e Marconi-100 del Cineca al nono. Così l'Italia è l'unica nazione europea con due supercomputer nella top ten. Non c'è male, anche se magari alla prossima classifica tutto sarà già cambiato.

Abbonati alla rivista ImpresaCity Magazine e ricevi la tua copia.

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Mag 08

RedHotCyber Conference 2025

Mag 08

Westcon - NIS2, DORA & AI Il futuro della Cybersecurity in Italia continua!

Mag 14

Huawei Enterprise Roadshow 2025 | Accelerating the Intelligent Italy - Roma

Mag 15

IDC Digital Infrastructure Summit 2025 - Milano

Mag 20

IT’S ALL BANKING & INSURANCE 2025

Mag 20

OVHcloud Summit 2025

Mag 21

Huawei Enterprise Roadshow 2025 | Accelerating the Intelligent Italy - Napoli

Mag 28

Huawei Enterprise Roadshow 2025 | Accelerating the Intelligent Italy - Messina

Mag 30

R1 GROUP BET FORUM 2025 - Milano