HPE: anche il supercomputing può essere as-a-Service

HPE applica il modello GreenLake ai sistemi di High Performance Computing, per unire performance da supercomputing con la semplicità del cloud

Quando si parla di "cloud experience" di solito si fa riferimento ad alcuni pilastri del modello as-a-Service per come le aziende possono viverlo oggi nel cloud pubblico. Pagamento a consumo delle risorse, automazione estesa dei processi di configurazione e gestione, attivazione e disattivazione self-service dei servizi e delle risorse, possibilità - per questi stessi servizi e risorse - di scalare a piacere e velocemente secondo le necessità del momento. Il risultato finale è genericamente una semplificazione dell'IT.

Uno scenario positivo. Ma - spiega Peter Ungaro, senior vice president and general manager, HPC and Mission Critical Solutions (MCS) di HPE - "di fatto le applicazioni che si potevano spostare facilmente sul cloud ci sono già arrivate". Resta una fetta ampia e maggioritaria di applicazioni e dati che resta fuori del public cloud per una serie di ragioni valide. Dalla volontà di avere sempre nei propri data center gli asset più critici dell'IT aziendale alla difficoltà di trasporre in cloud alcuni processi, sino a questioni di compliance normativa.

"I workload più esigenti sono i più complessi da modificare per poterli trasferire nel cloud pubblico", sottolinea Ungaro. E in questo ambito ricadono certamente i workload collegati all'High Performance Computing. È questo un settore che sta crescendo fortemente per i vantaggi che porta l'analisi massiva di dati, non solo ai centri di ricerca ma anche alle imprese. Ma che è tradizionalmente impostato sulla creazione di grandi sistemi che richiedono, per la loro implementazione, tempo e investimenti.

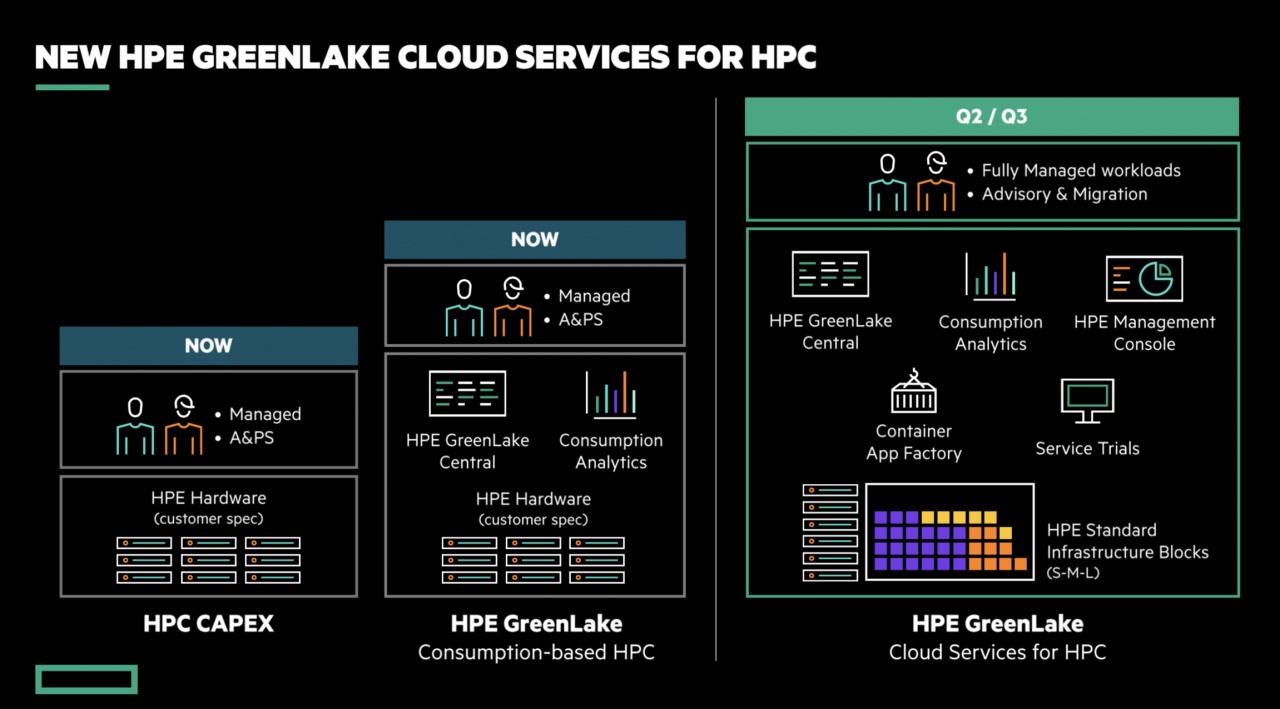

Portare all'HPC il modello as-a-Service è una possibile soluzione, HPE lo fa ora proponendo le sue tecnologie di HPC attraverso l'approccio di HPE GreenLake. Applicando cioè il modello del "cloud a casa del cliente" che ha già ottenuto buoni riscontri nell'IT generalista. Anche perché parlare di HPC sul cloud pubblico "puro" resta difficile. Le offerte ci sono, ma ci sono anche limiti tecnologici oggettivi e potenziali costi elevati quando si tratta di trasferire da/verso il cloud i grandi dataset tipici dell'elaborazione HPC.

Portare all'HPC il modello as-a-Service è una possibile soluzione, HPE lo fa ora proponendo le sue tecnologie di HPC attraverso l'approccio di HPE GreenLake. Applicando cioè il modello del "cloud a casa del cliente" che ha già ottenuto buoni riscontri nell'IT generalista. Anche perché parlare di HPC sul cloud pubblico "puro" resta difficile. Le offerte ci sono, ma ci sono anche limiti tecnologici oggettivi e potenziali costi elevati quando si tratta di trasferire da/verso il cloud i grandi dataset tipici dell'elaborazione HPC.

Qui l'as-a-Service di Greenlake ha il compito in primo luogo di ridurre le barriere all'accesso. Poi di semplificare le attività di configurazione e gestione dei sistemi HPC, con una semplificazione che ha effetti positivi anche sui costi di gestione.

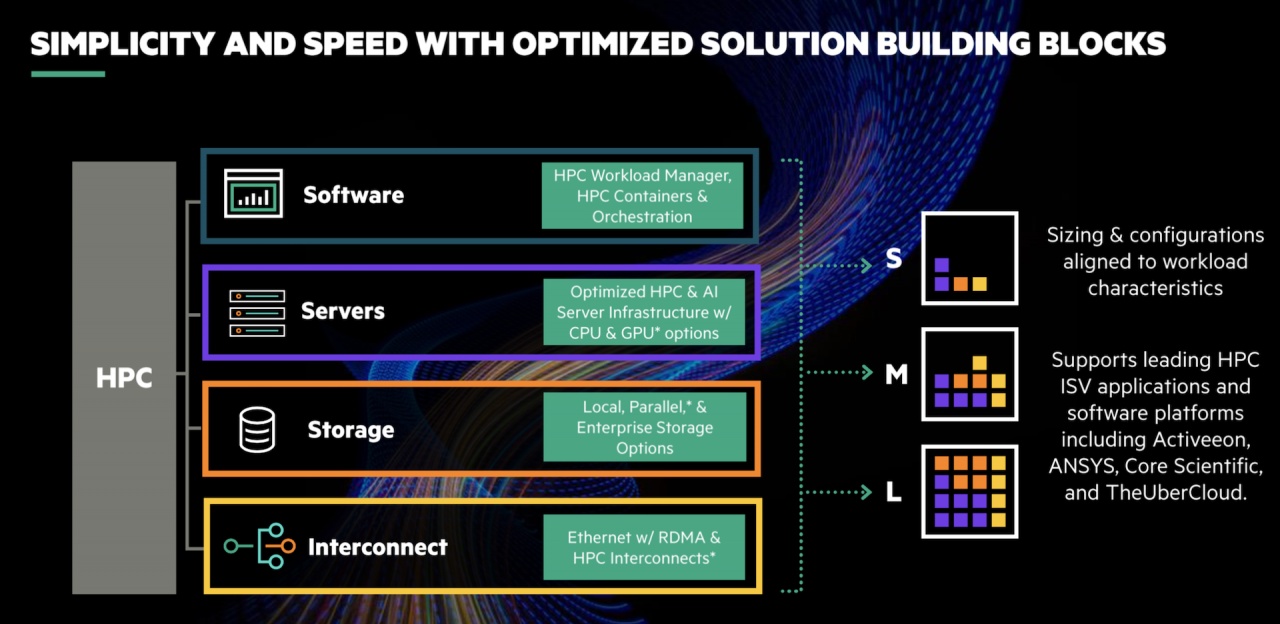

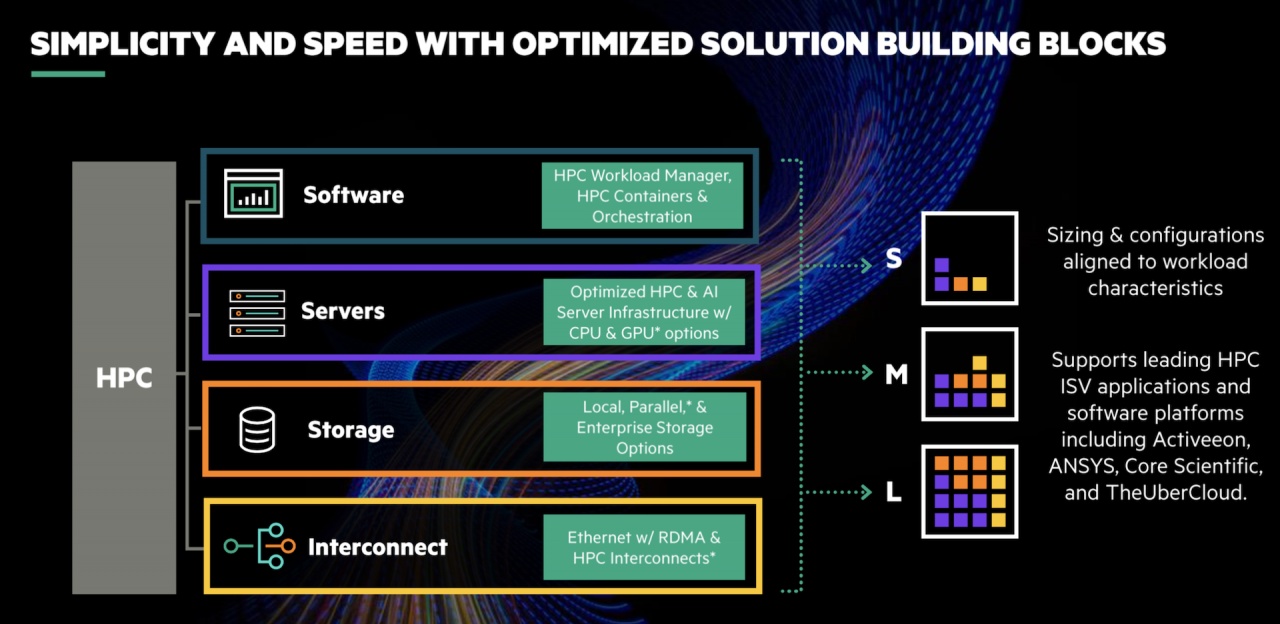

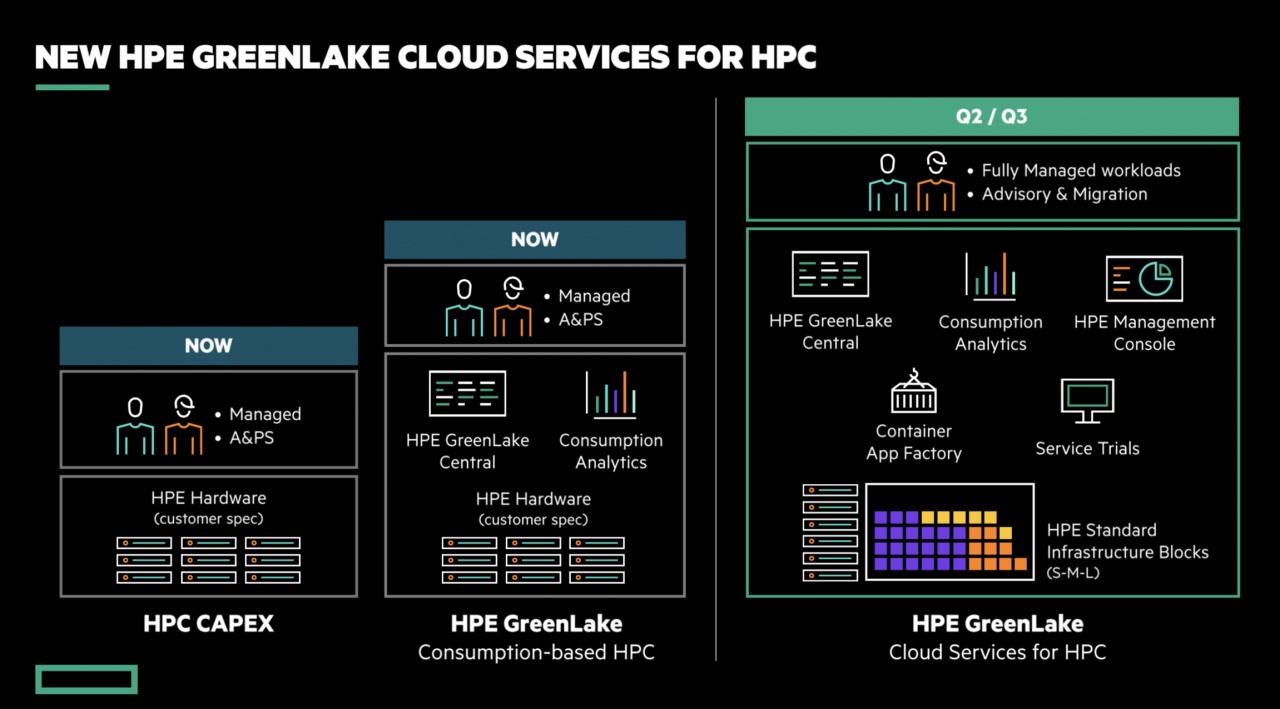

Per realizzare una nuova offerta HPC in logica GreenLake, HPE ha adottato un approccio modulare basato su "mattoncini" componibili - ovviamente di alto livello, visto che parliamo di High Performance Computing - per le parti di elaborazione, storage, networking. I primi elementi ad arrivare sul mercato saranno basati sui sistemi HPE Apollo e sono pensati in particolare per le attività di modellazione e simulazione. Seguiranno poi anche "composizioni" basate sull'offerta Cray.

L'obiettivo è semplificare l'avvicinamento delle aziende al computing ad alte prestazioni. Anche attraverso collaborazioni con gli ISV di vari settori verticali, in modo da poter proporre configurazioni GreenLake ottimizzate in partenza per tipo di mercato e settore applicativo, anche se sempre personalizzabili. "Così l'offerta HPC è standardizzata ma anche elastica, il che permette ai clienti di focalizzarsi sui risultati e non sulle architetture", sottolinea Ungaro.

L'obiettivo è semplificare l'avvicinamento delle aziende al computing ad alte prestazioni. Anche attraverso collaborazioni con gli ISV di vari settori verticali, in modo da poter proporre configurazioni GreenLake ottimizzate in partenza per tipo di mercato e settore applicativo, anche se sempre personalizzabili. "Così l'offerta HPC è standardizzata ma anche elastica, il che permette ai clienti di focalizzarsi sui risultati e non sulle architetture", sottolinea Ungaro.

Anche per questo una componente importante della nuova offerta HPC "aaS" è quella software. Con diverse componenti di derivazione GreenLake, come HPE GreenLake Central, e altre sviluppate per la gestione semplificata dei cluster di elaborazione, la containerizzazione dei workload HPC, l'analisi in tempo reale dei costi collegati all'uso delle risorse.

Peter Ungaro bada comunque a rimarcare che la "servitizzazione" dell'High Performance Computing non è una sua banalizzazione. Non può esserlo tecnicamente, ma soprattutto "far scalare verso il basso queste tecnologie, in un singolo rack o un singolo server che portiamo in qualsiasi data center, rappresenta una nuova era per il computing". In cui HPC non è più questione di costruire supercomputer più grandi ma piuttosto unire performance da supercomputer con la semplicità del cloud.

Uno scenario positivo. Ma - spiega Peter Ungaro, senior vice president and general manager, HPC and Mission Critical Solutions (MCS) di HPE - "di fatto le applicazioni che si potevano spostare facilmente sul cloud ci sono già arrivate". Resta una fetta ampia e maggioritaria di applicazioni e dati che resta fuori del public cloud per una serie di ragioni valide. Dalla volontà di avere sempre nei propri data center gli asset più critici dell'IT aziendale alla difficoltà di trasporre in cloud alcuni processi, sino a questioni di compliance normativa.

"I workload più esigenti sono i più complessi da modificare per poterli trasferire nel cloud pubblico", sottolinea Ungaro. E in questo ambito ricadono certamente i workload collegati all'High Performance Computing. È questo un settore che sta crescendo fortemente per i vantaggi che porta l'analisi massiva di dati, non solo ai centri di ricerca ma anche alle imprese. Ma che è tradizionalmente impostato sulla creazione di grandi sistemi che richiedono, per la loro implementazione, tempo e investimenti.

Portare all'HPC il modello as-a-Service è una possibile soluzione, HPE lo fa ora proponendo le sue tecnologie di HPC attraverso l'approccio di HPE GreenLake. Applicando cioè il modello del "cloud a casa del cliente" che ha già ottenuto buoni riscontri nell'IT generalista. Anche perché parlare di HPC sul cloud pubblico "puro" resta difficile. Le offerte ci sono, ma ci sono anche limiti tecnologici oggettivi e potenziali costi elevati quando si tratta di trasferire da/verso il cloud i grandi dataset tipici dell'elaborazione HPC.

Portare all'HPC il modello as-a-Service è una possibile soluzione, HPE lo fa ora proponendo le sue tecnologie di HPC attraverso l'approccio di HPE GreenLake. Applicando cioè il modello del "cloud a casa del cliente" che ha già ottenuto buoni riscontri nell'IT generalista. Anche perché parlare di HPC sul cloud pubblico "puro" resta difficile. Le offerte ci sono, ma ci sono anche limiti tecnologici oggettivi e potenziali costi elevati quando si tratta di trasferire da/verso il cloud i grandi dataset tipici dell'elaborazione HPC.HPC in versione GreenLake

In generale, HPE considera l'approccio GreenLake come un acceleratore nella diffusione dei sistemi HPC in casi d'uso ben identificati - progettazione, design, simulazione, analytics in tempo reale - e per settori altrettanto precisi: manufacturing, medicale, finanziario, energia. Sono ambiti e casi d'uso per cui l'High performance Computing è già considerato uno strumento molto utile. Ma che sinora hanno avuto un tasso di adozione delle nuove tecnologie HPC limitato dagli investimenti che le singole imprese dovevano mettere in campo.Qui l'as-a-Service di Greenlake ha il compito in primo luogo di ridurre le barriere all'accesso. Poi di semplificare le attività di configurazione e gestione dei sistemi HPC, con una semplificazione che ha effetti positivi anche sui costi di gestione.

Per realizzare una nuova offerta HPC in logica GreenLake, HPE ha adottato un approccio modulare basato su "mattoncini" componibili - ovviamente di alto livello, visto che parliamo di High Performance Computing - per le parti di elaborazione, storage, networking. I primi elementi ad arrivare sul mercato saranno basati sui sistemi HPE Apollo e sono pensati in particolare per le attività di modellazione e simulazione. Seguiranno poi anche "composizioni" basate sull'offerta Cray.

L'obiettivo è semplificare l'avvicinamento delle aziende al computing ad alte prestazioni. Anche attraverso collaborazioni con gli ISV di vari settori verticali, in modo da poter proporre configurazioni GreenLake ottimizzate in partenza per tipo di mercato e settore applicativo, anche se sempre personalizzabili. "Così l'offerta HPC è standardizzata ma anche elastica, il che permette ai clienti di focalizzarsi sui risultati e non sulle architetture", sottolinea Ungaro.

L'obiettivo è semplificare l'avvicinamento delle aziende al computing ad alte prestazioni. Anche attraverso collaborazioni con gli ISV di vari settori verticali, in modo da poter proporre configurazioni GreenLake ottimizzate in partenza per tipo di mercato e settore applicativo, anche se sempre personalizzabili. "Così l'offerta HPC è standardizzata ma anche elastica, il che permette ai clienti di focalizzarsi sui risultati e non sulle architetture", sottolinea Ungaro.Anche per questo una componente importante della nuova offerta HPC "aaS" è quella software. Con diverse componenti di derivazione GreenLake, come HPE GreenLake Central, e altre sviluppate per la gestione semplificata dei cluster di elaborazione, la containerizzazione dei workload HPC, l'analisi in tempo reale dei costi collegati all'uso delle risorse.

Peter Ungaro bada comunque a rimarcare che la "servitizzazione" dell'High Performance Computing non è una sua banalizzazione. Non può esserlo tecnicamente, ma soprattutto "far scalare verso il basso queste tecnologie, in un singolo rack o un singolo server che portiamo in qualsiasi data center, rappresenta una nuova era per il computing". In cui HPC non è più questione di costruire supercomputer più grandi ma piuttosto unire performance da supercomputer con la semplicità del cloud.

Abbonati alla rivista ImpresaCity Magazine e ricevi la tua copia.

Notizie correlate

Speciali Tutti gli speciali

Calendario Tutto

Apr 22

Webinar Docuware - Gestire al meglio le richieste di acquisto.

Mag 08

RedHotCyber Conference 2025

Mag 08

Westcon - NIS2, DORA & AI Il futuro della Cybersecurity in Italia continua!

Mag 14

Huawei Enterprise Roadshow 2025 | Accelerating the Intelligent Italy - Roma

Mag 15

IDC Digital Infrastructure Summit 2025 - Milano

Mag 20

IT’S ALL BANKING & INSURANCE 2025

Mag 20

OVHcloud Summit 2025

Mag 21

Huawei Enterprise Roadshow 2025 | Accelerating the Intelligent Italy - Napoli

Mag 28

Huawei Enterprise Roadshow 2025 | Accelerating the Intelligent Italy - Messina