Intel, a Innovation 2023 di scena anche la convergenza tra AI e sicurezza

Un approccio software-defined, silicon-accelerated basato su apertura, possibilità di scelta, fiducia e sicurezza. La collaborazione con Red Hat

Non c’è solo la Siliconomy nelle novità dell’evento Intel Innovation 2023 della scorsa settimana. L’annuale appuntamento dedicato in primis agli sviluppatori ha infatti costituito l’occasione per presentare un’ampia panoramica dell’ecosistema aperto di Intel, mostrando come l’approccio incentrato sugli sviluppatori garantisca che le opportunità dell'intelligenza artificiale siano accessibili a tutti.

Come noto, gli sviluppatori che desiderano cogliere tutto il potenziale dell'intelligenza artificiale si trovano ad affrontare sfide che impediscono l'implementazione diffusa di soluzioni per client ed edge, data center e cloud. Intel è impegnata ad affrontare queste sfide con un approccio software-defined e silicon-accelerated, fondato sull'apertura, la possibilità di scelta, la fiducia e la sicurezza. Fornendo gli strumenti che semplificano lo sviluppo di applicazioni AI sicure e facilitano gli investimenti necessari per mantenere e scalare tali soluzioni, Intel consente agli sviluppatori di portare l'AI ovunque.

In particolare, è stato sottolineato l'impegno nei confronti della sicurezza end-to-end, parlando tra l’altro della Intel Transparent Supply Chain per verificare l'integrità di hardware e firmware e garantire l'elaborazione riservata per proteggere i dati sensibili in memoria. Oggi Intel sta estendendo la sicurezza della propria piattaforma e la protezione dell'integrità dei dati con molteplici nuovi strumenti e servizi, inclusa la disponibilità generale di un nuovo servizio di attestazione.

Questo servizio è il primo di un nuovo portfolio di software e servizi di sicurezza denominato Intel Trust Authority. Offre una valutazione unificata e indipendente dell'integrità dell'ambiente di esecuzione, del rispetto delle specifiche e del tracciamento delle revisioni. Inoltre, può essere utilizzato in ogni ambiente che implementa il confidential computing di Intel, inclusi multi-cloud, ibridi, on-premise e all'edge. Intel Trust Authority diventerà inoltre una funzionalità integrata di abilitazione della confidential AI, contribuendo a garantire l'affidabilità degli ambienti informatici riservati in cui la proprietà intellettuale e i dati sensibili vengono elaborati in applicazioni di machine learning, inferendo in particolare sulle generazioni attuali e future dei processori Intel Xeon.

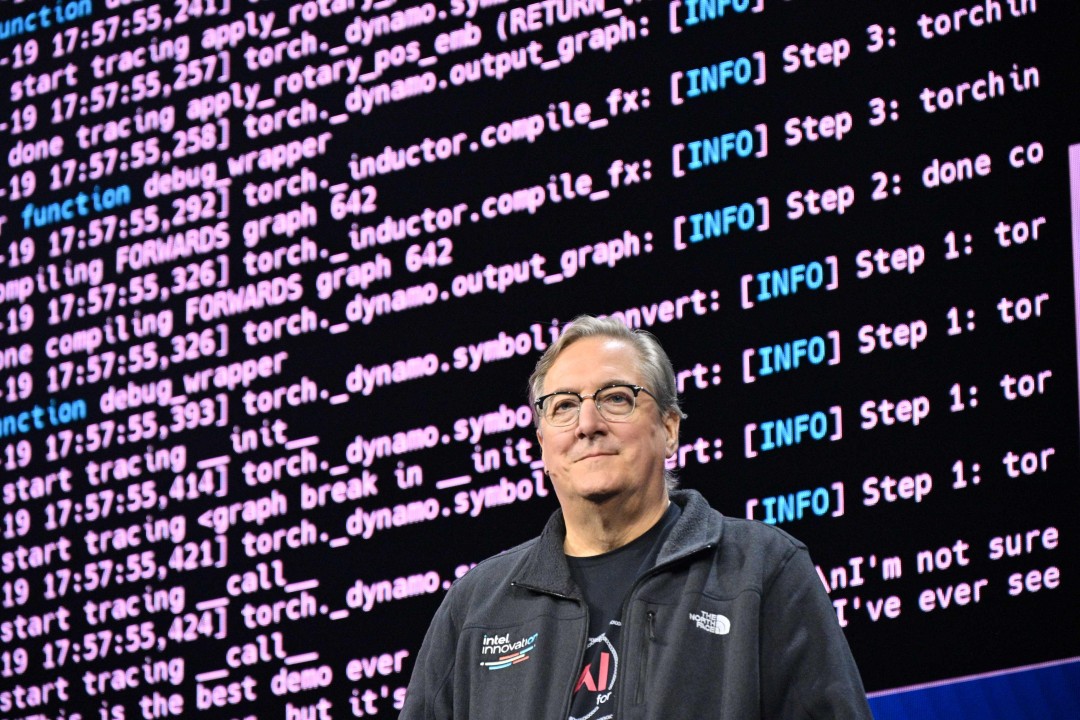

Greg Lavender, CTO di Intel, nel corso del suo intervento a Innovation 2023

Greg Lavender, CTO di Intel, nel corso del suo intervento a Innovation 2023

Un ecosistema aperto

Non solo: Intel è impegnata a promuovere un ecosistema aperto che consenta una facile implementazione su molteplici architetture. L’azienda è, tra l’altro, membro fondatore della Unified Acceleration Foundation (UXL) di Linux Foundation, organismo intersettoriale impegnato a creare un ecosistema software di accelerazione aperto per semplificare lo sviluppo di applicazioni per l'implementazione multipiattaforma. UXL è un'evoluzione dell'iniziativa oneAPI, il modello di programmazione di Intel che consente di scrivere il codice una sola volta e di distribuirlo su molteplici architetture informatiche, tra cui CPU, GPU, FPGA e acceleratori. Intel contribuirà alla UXL Foundation con la propria specifica oneAPI.

Intel sta inoltre collaborando con importanti vendor software, come per esempio Red Hat: al riguardo, Gunnar Hellekson, Vicepresidente e direttore generale di Red Hat Enterprise Linux Business, ha annunciato dal palco di Innovation 2023, insieme al Chief Technology Officer di Intel Greg Lavender, una collaborazione estesa che vedrà Intel contribuire al supporto upstream per l'ecosistema Red Hat Enterprise Linux (RHEL) utilizzando CentOS Stream. Intel continua inoltre a contribuire a tool e framework di intelligenza artificiale e machine learning quali PyTorch e TensorFlow.

Per aiutare gli sviluppatori a scalare le prestazioni in modo rapido e semplice, Intel Granulate aggiunge Auto Pilot per il corretto dimensionamento delle risorse dei pod Kubernetes. Lo strumento di ottimizzazione della capacità offrirà consigli automatici e continui sulla gestione della capacità per gli utenti di Kubernetes. Ciò consentirà loro di ridurre gli investimenti necessari per soddisfare i parametri costi-prestazioni negli ambienti containerizzati. Intel Granulate sta inoltre aggiungendo funzionalità di orchestrazione autonoma per i carichi di lavoro Databricks, che garantiranno una riduzione media dei costi del 30% e una riduzione dei tempi di elaborazione del 23% senza modifiche al codice1.

Gunnar Hellekson di Red Hat sul palco di Innovation 2023

Gunnar Hellekson di Red Hat sul palco di Innovation 2023

Il mondo fa sempre più affidamento sull’intelligenza artificiale per risolvere problemi grandi e complessi e ottenere ricadute reali sul business. Cresce di conseguenza la necessità di proteggere i modelli AI, i dati e le piattaforme su cui vengono eseguiti da manomissioni, manipolazioni e furti. La crittografia FHE (fully homomorphic encryption) consente di eseguire calcoli direttamente sui dati crittografati, anche se le implementazioni pratiche sono limitate dalla complessità computazionale e dal sovraccarico.

Infine, Intel ha in programma lo sviluppo di un acceleratore di circuiti ASIC per ridurre di milioni di volte il sovraccarico prestazionale associato a un approccio FHE esclusivamente software. Inoltre, l'azienda lancerà la versione beta di un toolkit software crittografato, che consentirà a ricercatori, sviluppatori e comunità di utenti di apprendere e sperimentare il coding FHE. Ciò avverrà entro la fine di quest'anno come parte di Intel Developer Cloud, la cui disponibilità generale è stata annunciata nel corso di Innovation, e includerà una serie di interfacce interoperabili per sviluppare software FHE, strumenti di traduzione e un simulatore di esempio del suo acceleratore hardware.

“La comunità degli sviluppatori è il catalizzatore che aiuta le industrie a sfruttare l’intelligenza artificiale per soddisfare le loro diverse esigenze, sia oggi sia in futuro L’AI può e deve essere accessibile a tutti per essere utilizzata in modo responsabile. Se gli sviluppatori sono limitati nella scelta dell’hardware e del software, il numero di casi d’uso per l’adozione dell’intelligenza artificiale su scala globale sarà limitato e probabilmente offrirà valore sociale altrettanto limitato”, ha commentato Greg Lavender.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

e. b.

e. b.