Dove sta andando lo storage enterprise?

Il modello STaaS è ormai una tendenza certa con tassi di crescita maggiori del 20%, mentre la tecnologia punta su sicurezza ed elaborazione integrate

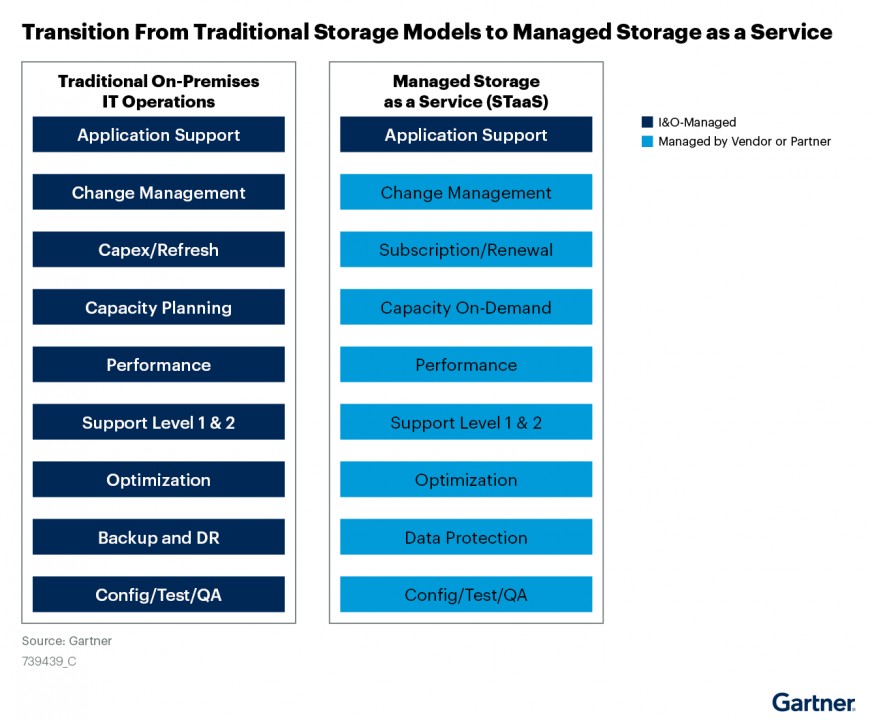

Iniziamo dai dati. Secondo le Top Predictions di Gartner, entro il 2025 il 40% delle nuove infrastrutture di computing e storage on-premise sarà as-a-Service, contro il 10% del 2021. Entro il 2028, le grandi imprese triplicheranno la capacità di dati non strutturati nelle sedi on-premise, edge e nel cloud pubblico rispetto a ora. Per avere un’idea del valore economico del comparto, dobbiamo fare una media tra le analisi disponibili. Si può concordare su una crescita della componente STaaS (Storage-as-a-Service) superiore al 20% anno su anno almeno fino al 2030. A partire da un valore molto approssimativo di circa 50 miliardi di dollari, ma comunque superiore ai 30, nel 2022.

Tra gli elementi trainanti di questa crescita, superiore a qualsiasi altra nel comparto IT, il più ovvio è l’incremento esponenziale dei dati generati dalle infrastrutture IT. Altro elemento da considerare è la necessità di una governance per le esigenze di protezione del dato, di una precisa strategia di disaster recovery e della garanzia di immediata disponibilità su architetture distribuite, anche per questioni di compliance.

Per questi motivi, lo storage si è già conquistato il primo posto nella lista delle priorità dei CIO, guadagnando qualche lunghezza nei confronti di computing e networking. E lo consideriamo as-a-Service, definitivamente sdoganato dalle varie offerte “a consumo” che i principali vendor di settore hanno portato sul mercato. Che prevedono di solito la fornitura di servizi di storage personalizzabili e scalabili a fronte di una fee fissa concordabile e negoziabile nel tempo, sia su cloud che on-premise.

Cosa ci aspetta per lo storage, dal punto di vista tecnologico? Le roadmap dei principali vendor hanno consacrato definitivamente la tecnologia flash in tutti i livelli di data storage: primario, secondario e terziario. Sebbene con qualche giustificata resistenza dei supporti tradizionali, soprattutto per il backup offline e in ottica di tutela dell’investimento. L’evoluzione, secondo Gartner, della tecnologia flash basata su QLC contribuirà a estenderne l’applicabilità sia in contesti mission critical sia in ambienti particolarmente sensibili ai costi.

La tecnologia QLC, a cella quadrupla, rappresenta l’evoluzione delle più comuni unità Triple Layer Cell. Se, a tendere, il costo per unità di storage delle SSD QLC sarà più conveniente delle SSD TLC, d’altro canto l’affidabilità, le performance e la durata delle unità a cella quadrupla sono ancora oggetto di discussione. Le performance generali dell’NVMe su TCP/IP, invece, trovano tutti d’accordo. L’intuizione di usare il bus PCI Express – seriale e con bassa latenza - per l’interscambio dei dati si dimostra decisamente felice e ora NVMe è l’abilitatore tecnologico definitivo del mondo storage enterprise.

Consulta il Focus Storage di ImpresaCity Magazine

Altra tendenza già evidenziata dai costruttori di memorie è l’integrazione dell’elaborazione all’interno delle unità di storage per compiti di decrittazione sull’unità stessa, ma anche per una prima scrematura dei dati utili, evitando così corposi trasferimenti di pacchetti di dati che gravano sulla rete.

Inoltre, sempre secondo Gartner, entro il 2028 tutte le soluzioni di storage includeranno funzioni di cybersecurity basate sulla difesa attiva oltre che sul recupero dei dati a seguito di un blocco. È il cyberstorage, la protezione integrata nelle appliance. Introdotta con il Cybersecurity Framework creato dal NIST, la direzione segue le linee guida sulla sicurezza per le infrastrutture di storage che sta già favorendo la diffusione di servizi per la protezione dei dati integrati nativamente nelle soluzioni.

Al secondo posto dopo l’STaaS, Gartner inserisce tra le esigenze primarie la necessità di gestire dati non strutturati, visto che entro il 2028 il 70% dei dati di file e oggetti sarà distribuito su piattaforme consolidate di storage di dati, appunto, non strutturati, un valore doppio rispetto al 2023. E lo si fa attraverso una piattaforma unica per l’esecuzione di servizi dati sia su file che su oggetti. Fonte: Gartner

Fonte: Gartner

Ma si prevede anche la diffusione di soluzioni di gestione che curino la classificazione dei dati e la creazione di metadati personalizzati. Ciò per garantire l’ottimizzazione dello spazio, la gestione dell’intero ciclo di vita dei dati, la riduzione dei rischi per la sicurezza. Ultima esigenza dettata dal mercato è la centralizzazione della gestione delle architetture distribuite geograficamente (cloud ed edge) attraverso dispositivi e piattaforme di archiviazione centralizzati, caching edge o con un file system globale virtuale.

Un cambio di mentalità

Abbracciare lo storage as-a-Service determina una revisione nell’approccio di progetto di vendor, partner IT e aziende clienti. C'è la necessità di una maggiore attenzione in fase progettuale con analisi preliminari precise dello stato dell’arte dell’architettura per comprendere i percorsi del dato, ma anche per salvare il salvabile in termini di infrastruttura. Soprattutto, si implementa il progetto sulla base delle esigenze future, partendo dall’assunto che il dato aumenterà in maniera esponenziale.

Per questo si diffondono sempre di più gli strumenti di capacity planning e di monitoraggio costante dell’infrastruttura di storage, in modo da fornire al cliente un’evidenza oggettiva preliminare dell’incremento dello spazio necessario e, di conseguenza, dei costi di gestione. In questo ambito si fa largo uso di machine learning e di automazione per scopi previsionali e per adeguamenti in tempo reale sia dello spazio occupato che della distribuzione dello storage sulle unità dislocate nei diversi luoghi fisici.

La trasformazione dello storage da architettura statica a un flusso dinamico di dati tra dispositivi strettamente interconnessi è concettualmente complessa da trasmettere ai responsabili IT. Perché un’entità distribuita, in continua mutazione, richiede un’intelligenza superiore nella sua gestione che non può essere delegata ai team interni. Questo approccio obbligato, come ogni modello as-a-Service, porta necessariamente a una stretta dipendenza del cliente dai vendor utilizzati e dai fornitori IT, con i suoi pro e i suoi contro.