Al Red Hat Summit 2024 il matrimonio tra open source e Gen AI

All'evento Red Hat di Denver si compie l’integrazione della Gen AI all’interno di tutta l’offerta del leader open source.

C’è un posto migliore della One Mile High City per radunare la community open source che opera al livello più alto dello sviluppo applicativo? Denver accoglie le migliaia tra sviluppatori, partner e giornalisti con vento e temperature coerenti con i suoi 1600 metri di altitudine, contribuendo a raffreddare le sinapsi messe a dura prova dalla due giorni del Red Hat Summit principale, quello americano appunto.

Si parla di AI, ovviamente, a Denver, Colorado, e soprattutto del colpo di fulmine tra open source e AI, e di come il matrimonio si debba considerare quasi inevitabile. Al Colorado Center apre le danze Matt Hicks, Ceo di Red Hat, seguito da Ashesh Badani, Senior Vicepresident e Chief Product Officer di Red Hat e il guru assoluto del movimento open, Chris Wright. Agli ultimi due il compito di presentare le numerose novità, mentre a Hicks spetta il compito di volare alto e raccontare, appunto, perché open source e AI sembrano nati l’uno per l’altro. Questione che tratteremo in un contributo a parte.

Qui, dunque, raccontiamo delle principali evoluzioni di prodotto esposte da Badani e Wright, avvertendo che gli argomenti trattati sono destinati a un pubblico decisamente tecnico. Ci si occupa, infatti, di quei livelli applicativi che è giusto rimangano trasparenti al cliente finale, ma che sono ormai ampiamente diffusi in una qualsiasi infrastruttura aziendale. Framework e livelli applicativi basati su codice aperto ben consolidati all’interno di ambienti cloud, la cui filosofia è ormai ben recepita da tutto l’ecosistema: vendor, partner e team interni di sviluppo. Soluzioni affidabili e qualitativamente eccellenti che oggi non devono più dimostrare niente, neanche in termini di sicurezza del codice.

Red Hat Enterprise Linux AI, per iniziare

Il suffisso AI si aggiunge alle diverse declinazioni dell’offerta Red Hat, in primo luogo in Red Hat Enterprise Linux AI (RHEL AI per gli amici). La definizione di Badani recita: “la piattaforma per sviluppare, testare ed eseguire i migliori modelli open source di IA generativa Granite a supporto delle applicazioni aziendali”. Dunque, uno strumento per lo sviluppo che sfrutta un modello di AI generativa a partire dall’LLM di IBM, Granite appunto, “ispirato” a Llama di Meta.

RHEL AI combina gli LLM Granite con licenza open source di IBM Research, insieme agli strumenti di allineamento dei modelli InstructLab, basati sulla metodologia LAB (Large-scale Alignment for chatBots), generando un'immagine RHEL ottimizzata e avviabile che semplifichi le implementazioni di tutto ciò che può essere generato usando Red Hat Enterprise Linux per qualsiasi obiettivo di sviluppo di codice, sia per l’hardware che per l’architettura software aziendale.

InstructLab è un progetto di intelligenza artificiale open source indipendente dal modello che aiuta a generare i contributi ai modelli linguistici di grandi dimensioni (LLM). “L'obiettivo principale di RHEL AI e del progetto InstructLab – ha spiegato Badani - è di consentire agli sviluppatori di contribuire direttamente ai modelli linguistici di grandi dimensioni con conoscenze e competenze. Permettendo così di creare in modo più efficiente applicazioni basate sull'intelligenza artificiale (come i chatbot)”.

Dunque, l’AI generativa a supporto dello sviluppo, o più propriamente degli sviluppatori, con l’obiettivo di semplificare notevolmente la scrittura del codice, rendendo la pratica accessibile a un maggior numero di utenti, anche a quelli non propriamente padroni di command e prompt. Ma non solo. La nuova offerta Red Hat + Gen AI.

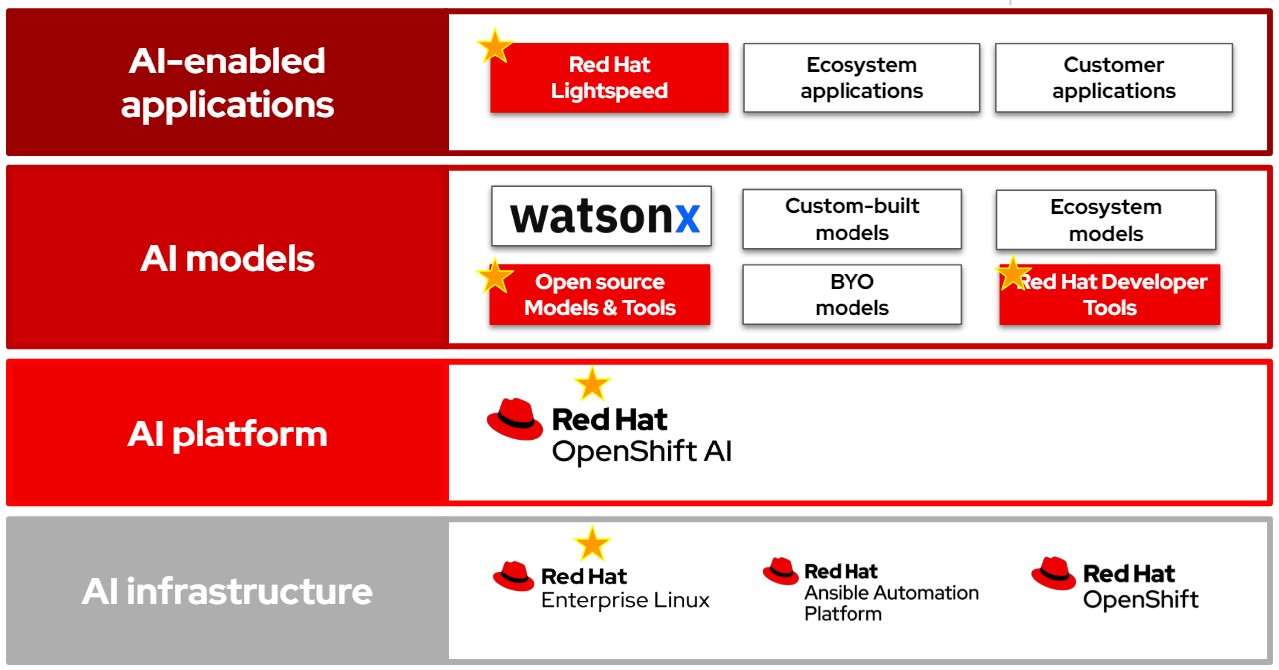

La nuova offerta Red Hat + Gen AI.

InstructLab per l’addestramento dell’LLM

Sono due le direzioni: da una parte, come detto, rendere la piattaforma di sviluppo intelligente per semplificare la creazione delle applicazioni o, più propriamente, la migrazione delle stesse su ambienti hybrid cloud con maggiore accuratezza e velocità (e per questo c’è Red Hat OpenShift AI di cui parliamo più in basso). D’altra parte, con InstructLab Red Hat spinge sulle skill, intese come bagaglio di conoscenza necessario al motore di LLM, con l’obiettivo di migliorarne e velocizzarne l’apprendimento ma anche di far crescere le competenze dei team di sviluppo, ancora poco preparati alla gestione dell’AI generativa.

Un bagaglio di conoscenza da formare soprattutto sulla base dei dati già presenti in azienda, dunque con una garanzia di qualità e di riservatezza dei dati, e sulle best practices messe a disposizione dalla community Red Hat. Il tutto seguendo la filosofia open source che negli anni ha consolidato Linux prima e Kubernetes dopo: “aspirando a ottenere da quattro a cinque volte i risultati attesi – afferma Badani -, bilanciando i costi e riducendo notevolmente la dipendenza dall’operatività umana (e quindi dai suoi errori, ndr) attraverso una piattaforma di semplice interazione e in continuo miglioramento, grazie al contributo costante della community”.

Ciliegina sulla torta degli annunci è qualcosa che rischia di passare inosservata ma che ci sembra decisamente innovativa. Si tratta dell’”image mode for Red Hat Enterprise Linux” che abilita per la prima volta il roll out e la gestione di un sistema operativo secondo i dettami della containerizzazione. Finalmente si potrà gestire tutto, dalle applicazioni al sistema operativo sottostante in un qualsiasi contenitore. Tutti beneficeranno della novità: dai clienti che godranno della semplicità di una gestione univoca via container, ai team di sviluppo che potranno intervenire “in tempo reale” nella risoluzione delle problematiche legate al codice, anche di sistema. Inoltre, la security sarà confortata dalle funzionalità di protezione tipiche di un container e, infine, i partner potranno distribuire il sistema operativo, insieme alle applicazioni, in modo univoco e snello.

Come con Linux e con Kubernetes, anche l’AI è “certificata” da Red Hat in termini qualitativi e di sicurezza, giusto per ribadire ancora una volta che open source fa rima con affidabilità. “È fondamentale stressare il concetto di certificazione – aggiunge Gianni Anguilletti, Regional Director dell’area mediterranea di Red Hat da 18 anni in azienda e osservatore lucido del contesto -. Da una parte siamo in grado di fornire un contributo altissimo allo sviluppo dei modelli di AI generativa, come già fatto nel caso dei container applicativi, grazie alla forza della nostra community. Dall’altra, qualsiasi prodotto o servizio inserito nell’offerta Red Hat è validato in ogni aspetto. I livelli di controllo e di validazione di tutto, dalla distribuzione al singolo aggiornamento, per noi rappresentano la migliore garanzia che possiamo fornire ai nostri clienti e che ci viene riconosciuta da tutti i partner, dai vendor agli MSP”.

Strizzare l’occhio ai partner di ecosistema

Si parla esclusivamente di hybrid cloud al Red Hat Summit 2024 di Denver perché, come ricorda ancora una volta Matt Hicks: “Red Hat è una platform company (totalmente devota al credo open source, ndr)”. Un’offerta che da oggi si avvale del supporto dell’AI e che si distribuisce su tutti i livelli dello stack applicativo, dall’infrastruttura, con RHEL AI, appunto, alla piattaforma con Red Hat OpenShift AI, fino alle applicazioni come Red Hat Lightspeed. Un’offerta che, evidentemente, strizza l’occhio ai partner di ecosistema – presenti a Denver più o meno virtualmente Intel, AMD e l’onnipresente Nvidia - ovvero OEM e produttori di GPU che potranno godere dell’AI secondo Red Hat nello sviluppo dei layer applicativi di gestione dell’hardware. Ma i partner di ecosistema sono, evidentemente, anche gli ISV e gli integratori di progetti architetturali, come Deloitte giusto per citarne uno.

Si comprende, così, che l’audience a cui sono destinati gli annunci del Red Hat Summit 2024 di Denver sia circoscritta a chi gli ambienti cloud ibridi contribuisce a costruirli, fornitori di hardware ma soprattutto Cloud Service Provider o MSP, fornitori di servizi gestiti, e boutiques consulenziali o integratori con un’infrastruttura IT a disposizione, non necessariamente proprietaria.

Il suffisso AI in Red Hat OpenShift, in particolare, espande la flessibilità dell'AI predittiva e generativa nel cloud ibrido. Così, la piattaforma MLOps per ambienti ibridi, unificata e pensata per creare, rinnovare e distribuire applicazioni su larga scala, lavorerà in modo più intelligente e rapido con un set completo di servizi per portare velocemente le app in produzione su ambienti cloud ibridi, in maniera totalmente indipendente dall’infrastruttura preesistente.

Da non dimenticare la Policy as Code per Red Hat Ansible Automation Platform, un tool per il monitoraggio delle policy lungo tutto il percorso di sviluppo di ambienti di automazione. È possibile personalizzare le policy e inserire check intermedi e sono disponibili i report richiesti dalla compliance aziendale.

Ancora, Red Hat Lightspeed godrà a breve dell’AI per supportare i team di sviluppo nell’amministrazione dei cluster e del sistema operativo, semplificare il planning di sviluppo, migliorare la sicurezza e, in definitiva, navigare più facilmente nella complessità delle architetture IT nel cloud ibrido.

Infine, Red Hat ha annunciato Podman AI Lab. Si tratta di un tool che supporta lo sviluppatore nella codifica e nell’esecuzione. Si può costruire un progetto di sviluppo localmente, su computer portatile, sfruttare l’AI generativa per accedere alle informazioni generate da determinati cluster di dati aziendali e, infine, intraprendere un percorso verso la produzione decisamente semplificato. La demo, particolarmente illuminante, di Podman AI Lab che abbiamo visto sul palco del Red Hat Summit 2024 di Denver è stata l’ulteriore conferma che lo sviluppo riga per riga è ormai da dimenticare, serve affidarsi a veri architetti del software competenti in AI, in attesa che le applicazioni aziendali scaturiscano da “conversazioni” tra due o più sistemi di AI generativa, come ha predetto Chris Wright, e gli specialisti dovranno solo monitorare che i sistemi non prendano derive “pericolose”.