La strada di AMD verso un computing ad alta efficienza

Per AMD la ricerca di maggiore potenza di calcolo non deve necessariamente rappresentare un rischio per la sostenibilità ambientale: le tecnologie sviluppate negli ultimi anni servono proprio a questo

La domanda di potenza computazionale è sempre in crescita e nulla fa nemmeno lontanamente immaginare una possibile frenata. Semmai, è proprio il contrario. Sta in primo luogo ai produttori di CPU soddisfare questa domanda di computing, progettando processori (e altri tipi di chip) sempre più performanti. Ma anche efficienti, perché il mantra dell'IT moderna è cercare di ridurre l'inevitabile impatto ambientale del computing in generale. Tra le varie conseguenze del boom mediatico dell'AI generativa c'è proprio aver portato in primo piano questo problema.

"Tutti i data center nel mondo si stanno confrontando con la richiesta di maggiore potenza di calcolo che l'AI comporta - conferma Alexander Troshin, Product Marketing Manager di AMD per l’area EMEA - ma anche con un aumento dei costi dell'energia che in particolare in Europa abbiamo sentito parecchio, negli ultimi due-tre anni". Rispondere a queste sfide richiede un non banale equilibrio fra gestione del preesistente, contenimento dei costi e apertura all'innovazione.

I vantaggi dell'innovazione

"La tendenza generale va verso l'ottimizzazione di quello che già si ha - spiega Troshin - e in questo senso vediamo che molti clienti hanno allungato i cicli di aggiornamento dell'infrastruttura IT, passando dai classici cinque anni anche a sette. Il che però significa usare tecnologie non più del tutto efficienti dal punto di vista energetico, né realmente performanti. Essenzialmente, questo significa sprecare energia senza una vera ragione valida".

L'ottimizzazione resta la strada da perseguire nei data center, ma richiede una progettualità di tipo diverso, capace di intervenire su molte componenti - dal design stesso dei data center alle tecnologie di raffreddamento, non solo sulle componenti di computing - in modo da definire un percorso che alla fine permetta, in sintesi, di fare di più con meno (energia). Una server consolidation che sfrutti le potenzialità delle nuove CPU è una parte importante di questa ottimizzazione. Ed è il concetto che AMD ha spinto negli ultimi anni con lo sviluppo dell'architettura Zen.

"L'idea - conferma Troshin - è dare la possibilità di consolidare i workload che già si eseguono su un numero minore di server e consumando meno energia. Per fare un esempio in campo AI, abbiamo un cliente che è passato da 15 server a 3 mantenendo la stessa potenza di calcolo. Il risparmio di energia gli ha consentito di aggiungere un ulteriore server dedicato ai workload AI, comunque mantenendo un consumo energetico minore rispetto alla configurazione di partenza".

Gli esempi virtuosi ci sono, certamente, ma pensare che il loro approccio si possa estendere a tutto il mercato rapidamente è peccare di ottimismo, al momento. "Ci vorrà del tempo - conferma Troshin - ma in generale credo che viviamo una fase molto interessante perché ora abbiamo le tecnologie che ci permettono di gestire la crescita della domanda di potenza di calcolo in modo intelligente. Usare la tecnologia più indicata - che siano CPU, GPU, FPGA o acceleratori specifici - dà comunque l'opportunità di crescere".

La spinta dei chiplet

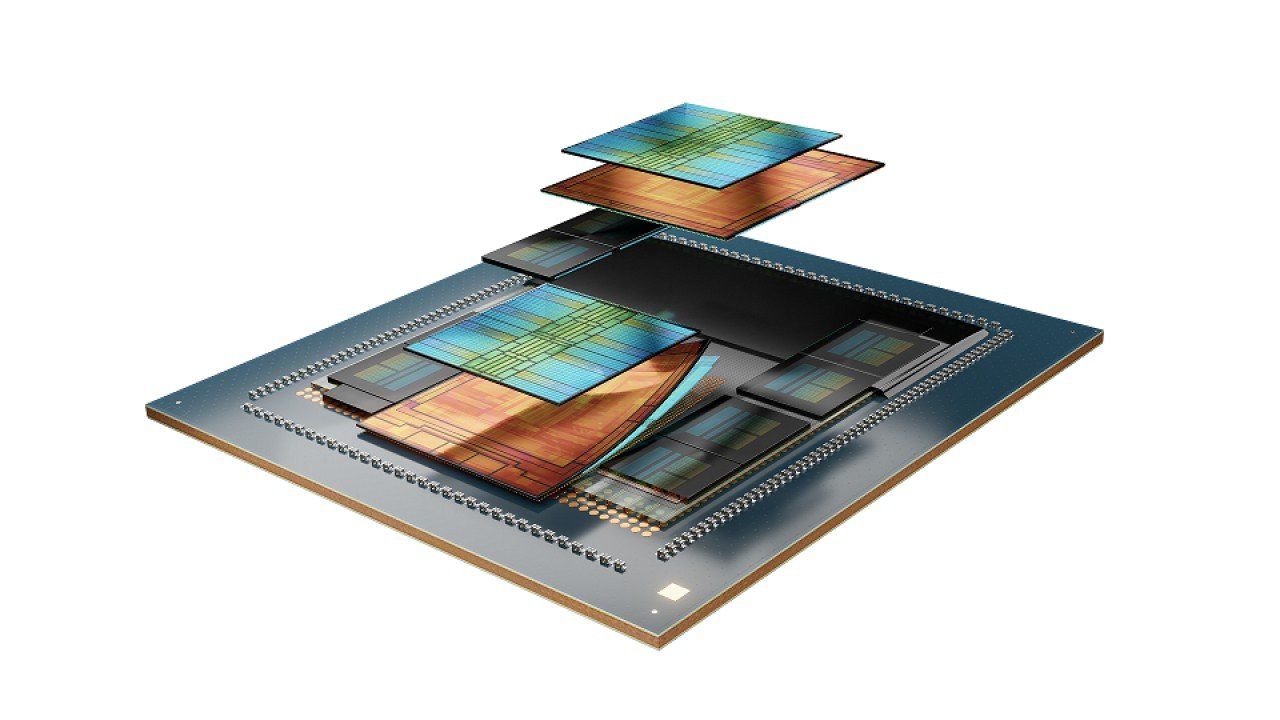

AMD si trova in una posizione di fatto privilegiata quando si parla di processori e altri chip che possono adattarsi a compiti specifici. Anche se oggi un po' tutti parlano di chip basati su architetture modulari, è stata AMD a industrializzare il concetto nel mercato dei processori da computer e server, sdoganandolo anche nelle applicazioni data center. A sei anni dal lancio del primo processore x86 con design a chiplet - erano i tempi delle CPU Epyc Zen 2 - questo background di esperienza tecnologica permette ora all'azienda di sviluppare rapidamente prodotti anche molto mirati.

"Grazie all'approccio chiplet - spiega Troshin - oggi possiamo adottare più rapidamente nuove tecnologie e riprogettare i chip e i loro layout per soddisfare le esigenze dei clienti o di particolari carichi di lavoro. Siamo anche in grado di sfruttare nuovi processi di produzione con i nostri partner, perché non abbiamo bisogno di riprogettare tutto il package per soddisfare un particolare requisito. Possiamo combinare gli elementi disponibili sul mercato nel miglior modo possibile. Era un'idea radicale, credo, quando abbiamo introdotto questa architettura sul mercato, sei anni fa".

Se consideriamo - semplificando molto - i chiplet come a una serie di "mattoncini Lego" che è possibile combinare a piacimento per definire una particolare architettura, si capisce come AMD possa ora pensare di ottimizzare i membri di una stessa famiglia di processori a compiti anche molto diversi fra loro. La latitudine di manovra oggi per AMD è notevole. "Possiamo ottimizzare le dimensioni del chip, riprogettare i chiplet, combinarli in modo da avere più canali di memoria, più I/O, più core, e così via, nei package più grandi. Oppure, dove non è possibile sfruttare un chip per data center completo e tradizionale, avere package mirati e più semplici. Significa poter combinare diverse tecnologie all'interno dello stesso chip e di trovare la soluzione giusta. Questo ci rende più agili rispetto ad altri operatori del mercato", spiega Troshin.

Questa ottimizzazione ha anche risvolti positivi per quanto riguarda il consumo di energia, da un lato perché porta a processori più performanti a parità di consumo, dall'altro perché consente di realizzare componenti mirati e non "sovradimensionati" per il loro effettivo utilizzo. In campo data center, le evoluzioni dell'architettura Zen sono state tali che nel 2020 AMD ha ufficializzato l'obiettivo di garantire entro il 2025 un aumento di 30 volte dell'efficienza energetica per le applicazioni di training dei modelli AI e di calcolo ad alte prestazioni. Questo rappresenterebbe, secondo 451 Resarch, una riduzione del 97% in cinque anni per la potenza necessaria a questi tipi di sistemi. Un obiettivo che, conferma Troshin, AMD sta effettivamente concretizzando.

Un mercato finalmente dinamico

Lo sviluppo del modello chiplet è forse la novità tecnologica di maggiore impatto nel design dei processori da data center, un ambito che è sempre stato visto come statico da buona parte delle imprese. In realtà questo non è mai stato del tutto vero e certamente non lo è oggi: più che di soli processori, ormai in campo data center bisogna parlare di architetture di calcolo eterogenee in cui le CPU “classiche” di uso generale sono affiancate da acceleratori specifici (dalle GPU alle TPU, con diversi altri componenti in mezzo) per carichi di lavoro mirati.

Questo vuole anche dire che la classica CPU x64 da server è minacciata da architetture emergenti alternative, come può essere ARM o persino Risc-V? Di ARM nel data center se ne parla da un decennio, ad esempio, ma Troshin resta prudente: "Lo stack tradizionale delle applicazioni per data center è sempre x64 e questo rappresenta una barriera elevata di accesso al mercato. C'è spazio per architetture alternative? Penso di sì. Ma tutto dipende dal caso d'uso specifico, dalle prestazioni necessarie, dalle considerazioni sull'efficienza energetica. Per la cronaca, noi usiamo un core ARM all'interno dei processori Epyc, per la gestione delle chiavi di sicurezza". Altri casi d'uso mirati potrebbero essere implementati allo stesso modo.

Tra questo e aspettarsi nel data center lo stesso boom che ARM sta avendo nel mondo notebook, però, ce ne passa. "Non credo che ARM o altre architetture possano superare la quota di mercato di x86 nel breve termine e nemmeno nel medio periodo", commenta Troshin. Che però sottolinea anche l'importanza di avere un mercato comunque dinamico: "Molti operatori, in primis gli hyperscaler, stanno lavorando a propri chip, anche partendo da progetti open source. Noi stessi collaboriamo a stretto contatto con aziende del calibro di AWS, Microsoft o Google, non solo per le applicazioni delle CPU tradizionali ma anche per quanto riguarda la validazione di architetture e design diversi. Abbiamo team che se ne occupano, anche se naturalmente non divulghiamo i dettagli di ciò che stanno facendo esattamente".

Non è poi da sottovalutare la crescita dei progetti open hardware o comunque basati su standard aperti, come in primo luogo l'Open Compute Project. "Nel mondo 'open' c'è molto potenziale - conferma Troshin - e AMD è impegnata anche in questo ambito, per quanto riguarda tanto l'ecosistema software quanto l'ecosistema hardware. Non credo che gli standard aperti siano ancora del tutto maturi e la tecnologia proprietaria continua a guidare il mercato. Ma vedremo comunque nascere sempre più progetti personalizzati". Anche da questo punto di vista il dinamismo del mercato, per fortuna, non manca.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

f.p.

f.p.