La GenAI ha un problema di dati. Già adesso.

I progetti pilota di AI generativa indicano che la qualità dei dati di partenza è un limite chiave all’implementazione in produzione di applicazioni con un ROI sufficiente

Da quando c’è stato il primo forte incremento nell’interesse per l’AI generativa – quindi da un paio d’anni almeno – si è sempre saputo che per la GenAI, come peraltro per tutte le applicazioni dei principi del machine learning, la qualità dei dati usati per addestrare modelli e algoritmi era, e sarebbe sempre più stata, un fattore chiave nella realizzazione di applicazioni efficaci. Il problema sembrava spostato in avanti nel tempo, soprattutto alle aziende che avevano sinora pensato relativamente poco all’AI. Invece, pare una questione di cui occuparsi in fretta.

Il problema ha diverse dimensioni. In primo luogo, si sapeva che i modelli generativi pubblici – addestrati sulla base di contenuti più o meno "liberamente" disponibili online, quindi alla fine su una medesima base dati – avrebbero iniziato ad essere troppo poco differenziati fra loro proprio per la “radice” comune. Ma si ipotizzava che questo fenomeno sarebbe stato lento, e invece lo sviluppo di molti modelli alternativi si è accelerato e questa “omogeneizzazione” si sta mostrando già adesso.

Per le applicazioni aziendali questa dinamica ha però una importanza relativa. Le imprese più grandi e interessate alla GenAI hanno capito rapidamente che la strada da seguire, sebbene certo non semplicissima, è partire da un modello di AI generico per poi arricchirlo “privatamente” – anche per ovvie considerazioni di privacy e strategicità dei dati – con dati propri. Da qui il grande interesse per le tecniche cosiddette di RAG (Retrieval Augmented Generation), che fanno proprio questo.

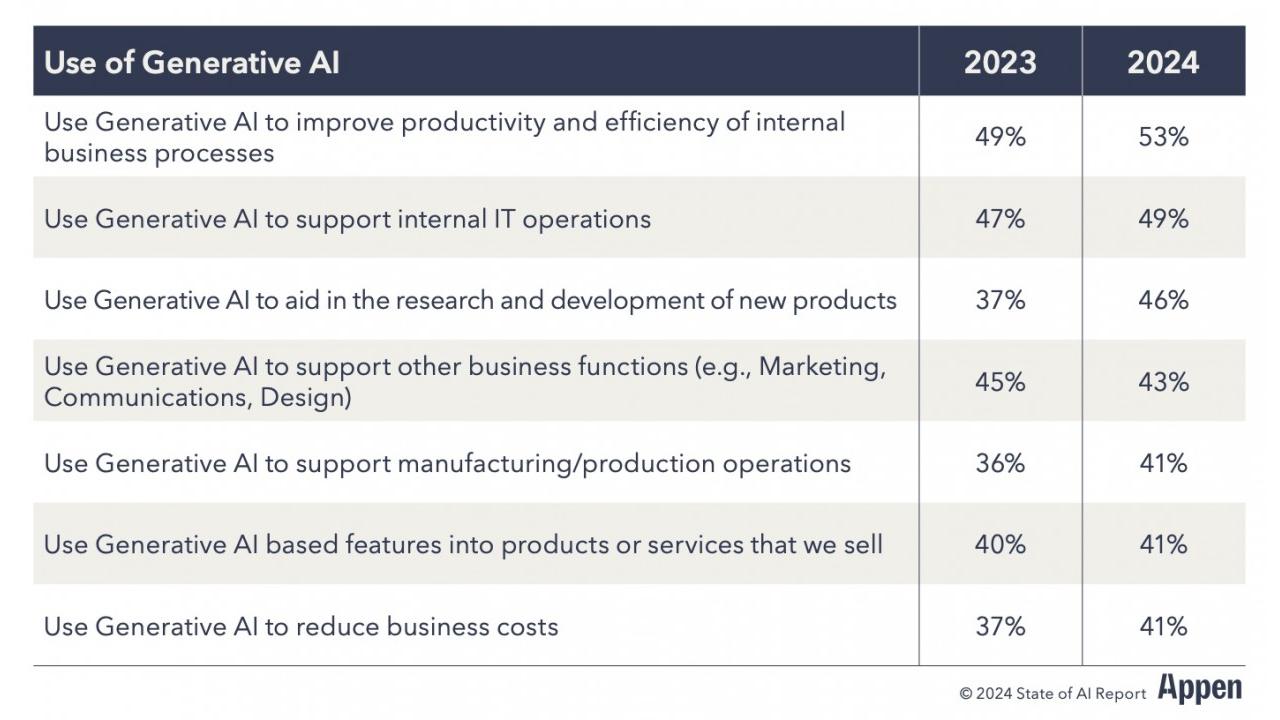

La questione però non è risolta affatto e nemmeno rimandata, come testimonia una analisi di Appen condotta su un campione di grandi imprese statunitensi. I dati raccolti indicano che la GenAI è sempre più interessante per le aziende – tra il 2023 e il 2024 la percentuale delle aziende che l’hanno adottata è passata dal 39 al 56 percento – ma che la maggioranza ha riscontrato troppi problemi di bias e di accuratezza dei modelli di partenza.

Per contenere questi problemi le aziende ricorrono a dati supplementari: dati raccolti in modo specifico e personalizzato (nel 41% dei casi), a dati sintetici (30%) e a dati che sono “pre-etichettati” da esperti e quindi la cui qualità è in qualche modo certificata. Questi dati aggiuntivi, personalizzati e di qualità, servono per ri-addestrare i modelli di GenAI di partenza, una operazione non scontata che però la gran parte (86%) delle imprese del campione esegue almeno una volta a trimestre.

E attenzione, avvisa poi l’80% del campione: anche con questi miglioramenti nella qualità e nella varietà dei dati, il buon funzionamento degli algoritmi di GenAI è ragionevolmente garantito solo se il loro apprendimento avviene anche attraverso l’interazione con il personale umano. Più tecnicamente, a funzionare meglio sono cioè le forme di machine learning cosiddette “human-in-the-loop”.

I dati alla prova dei fatti

Che ci sia un problema di dati da risolvere lo indica anche la stima che le aziende del campione hanno fatto sulla accuratezza dei dati usati per i loro progetti di AI. È una stima che sta progressivamente calando negli anni – nel 2021 era al 63,5%, nel 2024 al 54,6% - perché all’aumentare del numero e della complessità delle applicazioni di AI il “nodo” dei dati di qualità viene al pettine. Ma avere dati di qualità adeguata non è semplice, indicano le imprese, e non lo è neanche gestirli in una “data pipeline” adeguata in generale e per l’AI in particolare.

Nella gestione dei dati per l’AI ci sono infatti molti colli di bottiglia, indica l’analisi Appen. Soprattutto mancano le soluzioni adeguate di data management (lo indica il 48% del campione), gli skill tecnici per gestire al meglio i dati (38%), i tool tecnici specifici (32%), i dati adeguati stessi (29%).

Il risultato di tutto questo è che la GenAI, pur piacendo molto, sta deludendo le aspettative e fa sempre più fatica a passare dallo stadio dei progetti pilota alla produzione. Soprattutto perché chi in azienda deve decidere non vi vede un ROI adeguato. In una flessione lenta ma costante, spiega Appen, dal 2021 al 2024 la percentuale dei progetti implementati che hanno mostrato un ROI “significativo” è passata dal 56,7% al 47,3%. Nello stesso periodo, la quota dei progetti pilota che sono passati in produzione è scesa dal 55,5 al 47,4 percento.

Altre analisi di mercato hanno dato percentuali anche più problematiche, ma la questione resta. Anche perché – lo spiegava tempo fa Gartner – il principale ostacolo che la GenAI trova nelle imprese sta nella difficoltà di stimare precisamente e di dimostrare il ROI dei progetti di AI.