NetApp Insight Xtra 2024, unificare i dati per l’AI

Il CEO George Kurian e il Country manager per l’Italia Davide Marini illustrano le strategie necessarie per gestire al meglio i dati nel contesto sfidante dell’intelligenza artificiale generativa

Location d’eccezione per la tappa italiana di NetApp Insight Xtra. Si è infatti svolto a metà dicembre presso il Global Cloud Data Center di Aruba, a Ponte San Pietro alle porte di Bergamo, l’evento organizzato da NetApp per clienti, partner ed esperti del settore. Gli oltre 400 intervenuti hanno potuto vivere una densa giornata dipanatasi attorno al tema delle infrastrutture intelligenti cloud e dati al servizio delle sfide di business di oggi, tra le quali in primo piano l’AI generativa.

Ospite d’eccezione, George Kurian, Ceo di NetApp, presente per la prima volta in Italia, al quale hanno fatto da corollario le testimonianze di Aruba, IEO, CSI Piemonte, Cineca e Ducati: quest’ultima, che ha in atto da anni una partnership tecnologica con NetApp e Aruba, è stata introdotta da Giovanna Sangiorgi, Senior vice president e General manager di NetApp.

La partnership con Aruba

La scelta dell’Auditorium di Aruba all’interno del Global Cloud Data Center non è casuale, visto che dallo scorso settembre NetApp è il fornitore preferenziale di infrastrutture dati per Aruba: le due aziende hanno infatti siglato un accordo per unire le rispettive competenze per offrire nuove soluzioni marchiate “Powered by NetApp”. Al riguardo, rispondendo a una domanda di ImpresaCity, George Kurian ha così sottolineato i motivi della partnership con Aruba: “ritengo che innanzitutto l'economia dei data center si basi sul principio che più grande è il data center più è efficiente. Non vedo altri in grado di costruire una struttura di data center sofisticata come quella di Aruba. Certamente si possono aggiungere capacità, ma è il dimensionamento e l'investimento iniziale che rappresentano il principale contributo per migliorare l'efficienza in un grande data center”.

Non solo: “rispetto al numero elevato di data center privati, il livello di investimento che questi clienti privati possono dedicare all'innovazione nei data center non è paragonabile a quello di un provider specializzato, che fa di questo il proprio core business. E questo è anche il motivo principale per cui uno specialista di data center riesce sempre ad aggiungere valore in termini di miglioramento dell'efficienza e di riduzione dei costi”.

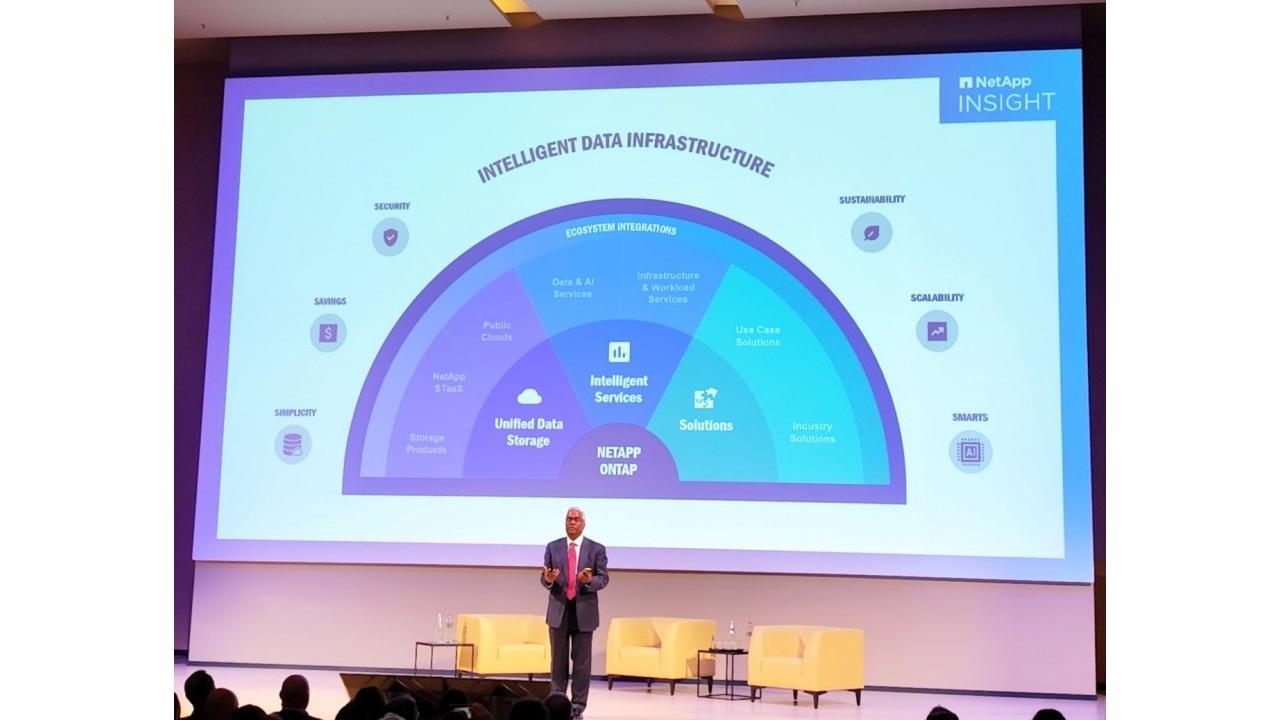

L'Intelligent Data Infrastructure

Nel suo keynote, George Kurian ha ribadito più volte l’importanza di avere oggi un’infrastruttura dati intelligente e soprattutto unificata, sottolineando che “se l’emergere dell’AI generativa non ha ridotto l’importanza di gestire, proteggere e mantenere privati i propri dati, ha però determinato la necessità di unificare tutti i dati per comprendere meglio il proprio business e applicare strumenti di intelligenza avanzata, ora facilmente accessibili, per analizzare e sfruttare i dati aziendali in modo più efficace”.

È proprio per questo che occorre “un’infrastruttura intelligente che consenta di unificare tutti i dati dell’azienda: una delle sfide principali per molte imprese nell’era dell’intelligenza è la frammentazione dei dati, sparsi tra sistemi, infrastrutture, soluzioni on-premise e cloud”.

In realtà, ha proseguito Kurian, NetApp affronta questo tema da tempo, con soluzioni di unified storage introdotte già molti anni fa: “dal 2004 abbiamo integrato file e block storage, poi abbiamo aggiunto anche l’object storage e l’integrazione tra on-premise e cloud, che ha permesso ai clienti di utilizzare i dati in cloud insieme a quelli nei loro data center, integrando le applicazioni su entrambe le piattaforme. Ecco perché chi ha costruito la propria infrastruttura su NetApp può adottare più rapidamente architetture come Kubernetes, data lake o nuovi modelli di sicurezza, mentre chi lavora con dati in silos incontra difficoltà operative. Non solo: abbiamo anche sviluppato una suite di servizi avanzati per rendere più semplice ed efficace la governance e la gestione dei dati, e tutti i nostri sistemi sono basati sulla stessa architettura software, il che semplifica la gestione operativa e riduce i rischi, perché un’architettura unificata è fondamentale anche ai fini della sicurezza, oggi più che mai fondamentale nell’era dell’AI”.

Sicurezza in primo piano

A proposito di AI e sicurezza, George Kurian sottolinea che “utilizziamo l'intelligenza artificiale come strumento per proteggere i dati: da tempo integriamo strumenti di AI nel nostro software di gestione dei dati e continuiamo a migliorare queste capacità per rilevare minacce quasi in tempo reale, oltre a creare copie dei dati estremamente sicure a prova di manomissione, da cui è possibile recuperare i dati in modo affidabile”.

Di più: “per quanto riguarda il supporto alle funzionalità di AI per i clienti, abbiamo sviluppato un'architettura scalabile, ovvero un sistema clusterizzato e distribuito che può raggiungere livelli di performance estremamente elevati. Siamo certificati da Nvidia per SuperPOD e altre soluzioni, e portiamo queste stesse capacità anche nel cloud pubblico, integrandoci con Amazon, Microsoft, Google Cloud e altri cloud provider in tutto il mondo”.

Tutto questo si inscrive nella visione prospettica di NetApp nei confronti dell’AI: visto che come noto l'AI generativa è tanto più performante quanti più dati gli si possono dare in pasto, e più velocemente, ne consegue che per avere il massimo dall'AI occorre riprogettare le architetture storage che gestiscono i dati, cambiando il modo in cui lo storage si interfaccia con le componenti di AI e portando parte delle future funzioni di AI a bordo dello storage stesso.

Come ha sintetizzato Geoge Kurian, NetApp “sta sviluppando tre innovazioni fondamentali per affrontare le sfide legate ai dati nell'ambito dell'AI: la prima consiste nel comprendere e gestire efficacemente i dati per l'AI, la seconda, invece di trasferire tutti i dati in un silos dedicato all'AI, consiste nel portare l'AI ai dati, rendendo molto più semplice implementare soluzioni di AI nell’ambiente dei clienti. Infine, la terza è integrare i sistemi e l'architettura di AI nei processi aziendali e nell'architettura dei dati dell’azienda, per poterli gestire e trarne vantaggio lungo tutto il loro ciclo di vita”.

Crescita superiore al mercato

Introducendo la giornata prima di cedere il palco al CEO, Davide Marini, Country manager di NetApp Italia, ha sottolineato che NetApp è stata appena confermata da IDC come lo storage vendor che sta crescendo di più nel mercato SAN e NAS in Italia negli ultimi quattro anni, e questo “conferma che il mix di investimenti che abbiamo fatto va nella direzione giusta”.

Ripercorrendo brevemente la storia tecnologica di NetApp, Davide Marini ha ricordato che “da trent’anni sul mercato e siamo passati attraverso diverse ere, dall'era in cui la priorità era quella di unificare la gestione dei dati, per la quale abbiamo creato l'innovazione dell’unified storage. Poi siamo passati nell’era in cui gestire i dati ovunque essi fossero all'interno di un cloud ibrido era prioritario, e quindi abbiamo proposto la nostra visione e la nostra strategia di data fabric, sul quale spostare i dati in maniera semplice e sicura. Successivamente, c’è stata la gestione del dato su ambienti hybrid multi cloud, e qui siamo stati i primi ad avere un offering certificato e attivamente integrato all'interno dei public service provider, estendendo il concetto di data fabric all’hybrid multi cloud”.

Oggi che siamo nell'era dei dati e dell'intelligenza, ha proseguito Davide Marini, lo step di NetApp è quello di un “percorso di trasformazione ulteriore delle proprie tecnologie per renderle intelligenti, perché avere tecnologie che sono soltanto reattive non è più sufficiente per poter vincere le nuove sfide”.

Semplificazione ed efficienza

Sono infine stati toccati anche altri temi, come tra gli altri quello della semplificazione e quello dell'efficienza: “in un sistema sempre più complesso, noi continuiamo a lavorare per semplificare, per esempio con il sistema operativo OnTap, disponibile sia on-prem sia nei public cloud provider, che semplifica la gestione dei dati in quanto è altamente automatizzato e centralizzato nella gestione, mentre per il risparmio le nostre tecnologie avanzate in termini di compressione e di deduplica, unitamente ai nostri modelli di pagamento a consumo, permettono alle aziende di ridurre i costi sia operativi sia di capitali”, ha concluso Davide Marini.

Rimani sempre aggiornato, seguici su Google News!

Seguici

Rimani sempre aggiornato, seguici su Google News!

Seguici

Edoardo Bellocchi

Edoardo Bellocchi